苏生不惑原创文章,加入我的知识星球

5年来苏生不惑这个公众号已经写近400多篇原创文章,去年分享过2023 更新版:苏生不惑开发过的那些原创工具和脚本 2024 公众号苏生不惑发布软件目录 ,今天整理更新下2024版,有问题加微信

公众号分享过的上千个软件都同步到我的知识星球了正式介绍下我的知识星球 ,这个星球运营2年多了,星球内可以提问,交流,而且搜索方便,比微信群好用多了,欢迎加入2024 极品互联网宝藏资源库知识星球,聚合全网资源,低调收藏

公众号

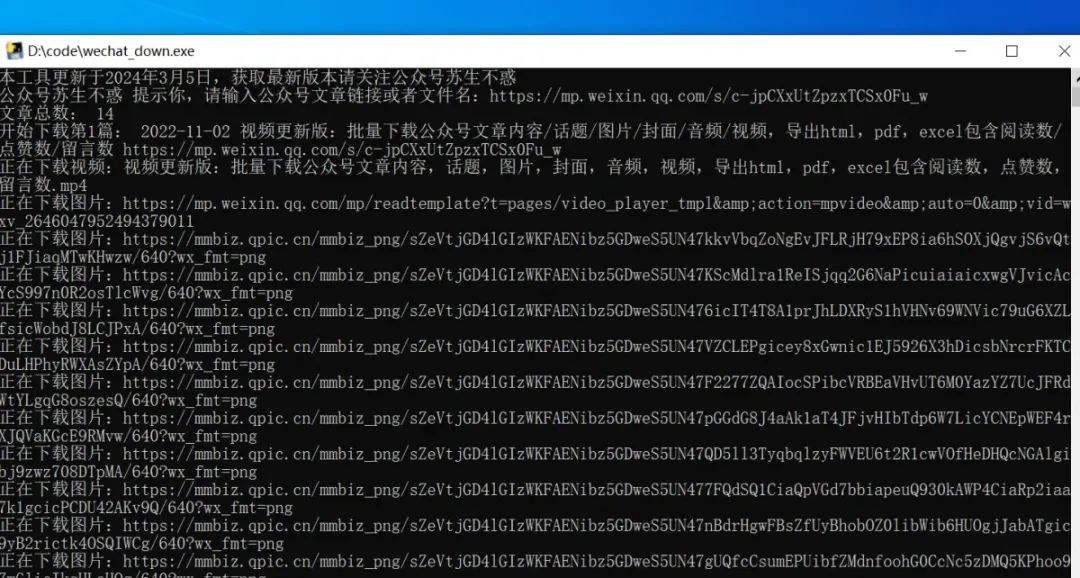

以下载这篇文章视频更新版:批量下载公众号文章内容/话题/图片/封面/音频/视频,导出html,pdf,excel包含阅读数/点赞数/留言数 为例,打开wechat_down.exe输入文章链接https://mp.weixin.qq.com/s/c-jpCXxUtZpzxTCSx0Fu_w 或者包含文章链接的文件名。 工具下载地址在公众号后台对话框回复

工具下载地址在公众号后台对话框回复

我录制了个简单的视频:

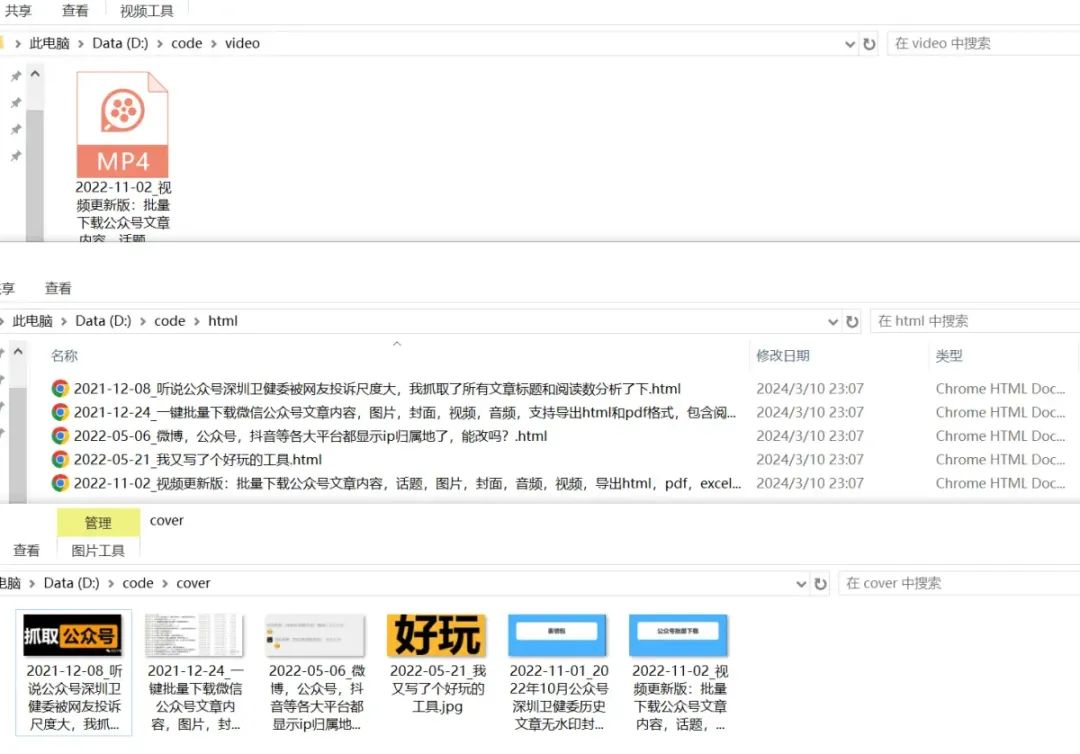

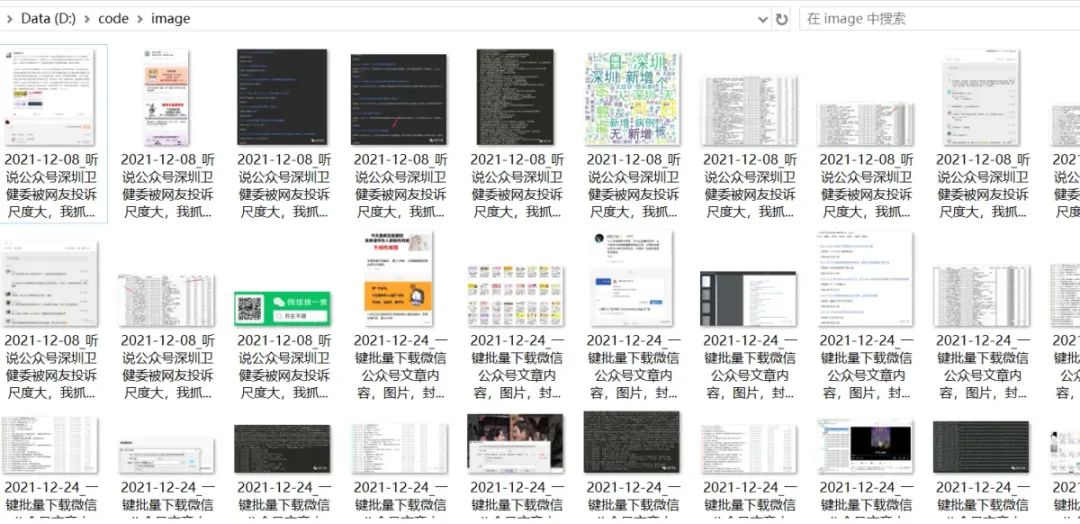

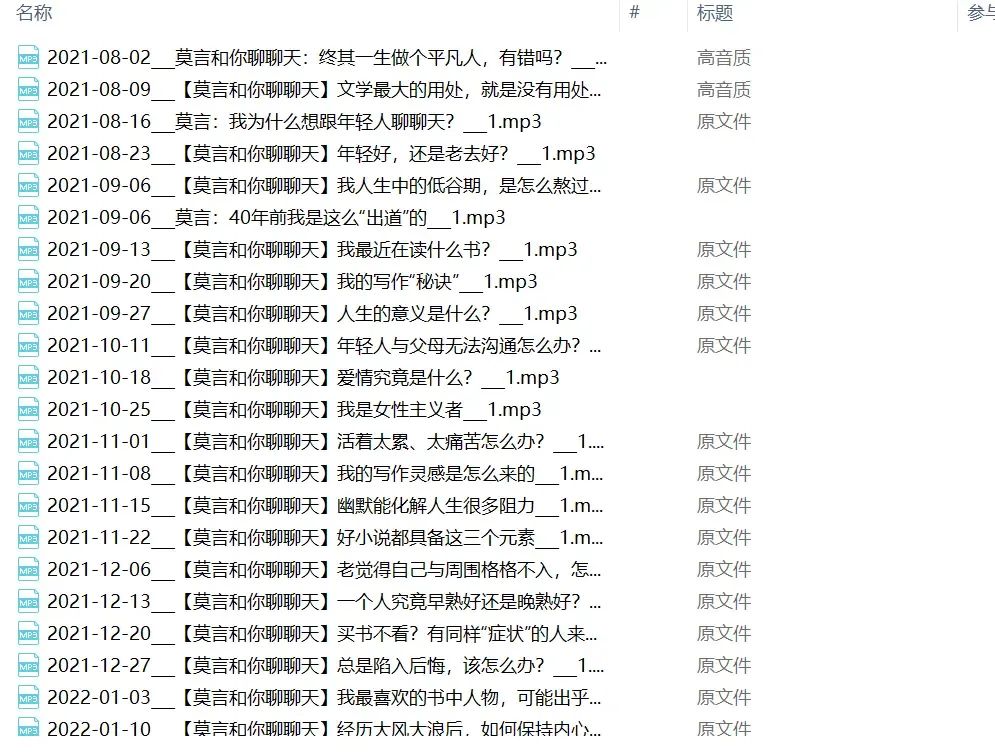

默认会下载文章和文章里的文章,下载的音频保存在audio目录,视频保存在video目录,封面保存在cover目录,图片保存在image目录,文章内容保存在html目录。

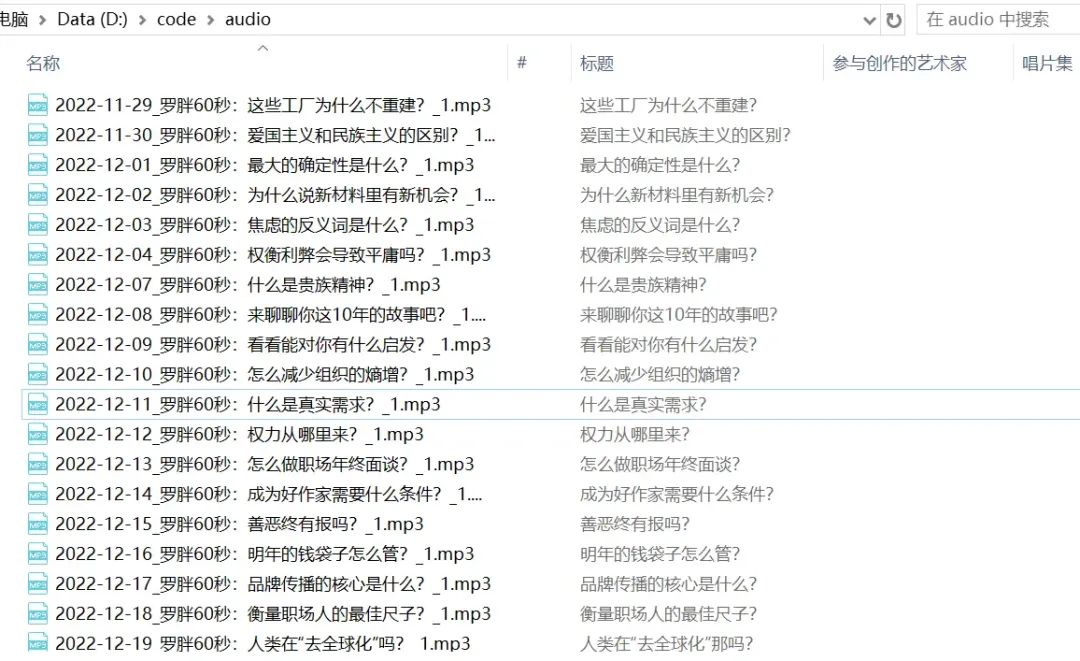

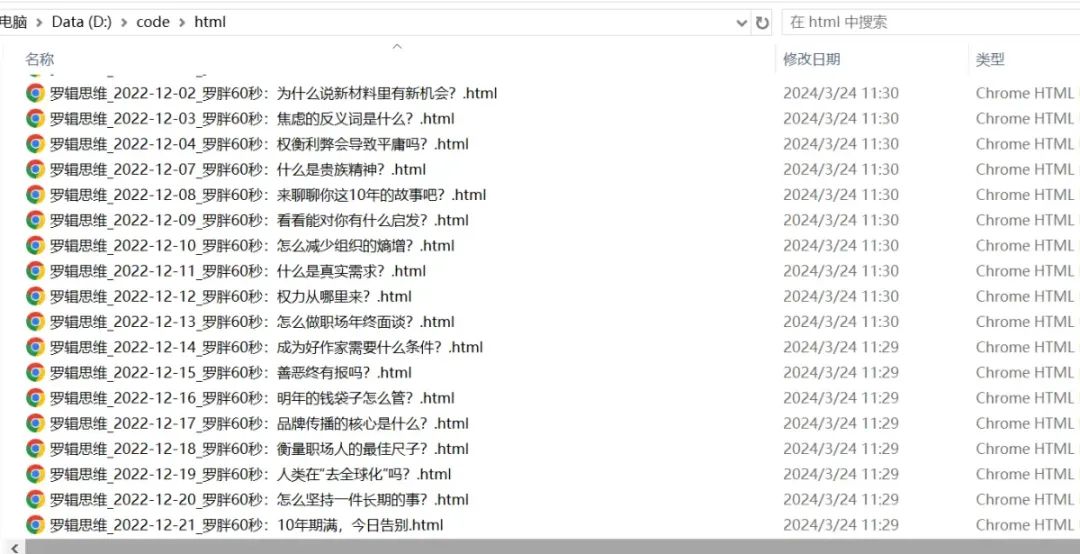

除了公众号文章下载,公众号话题下载也是一样的,比如罗胖60秒这个话题https://mp.weixin.qq.com/mp/appmsgalbum?__biz=MjM5NjAxOTU4MA==&action=getalbum&album_id=1681628721901830149&scene=173&from_msgid=3009294038&from_itemidx=1&count=3&nolastread=1

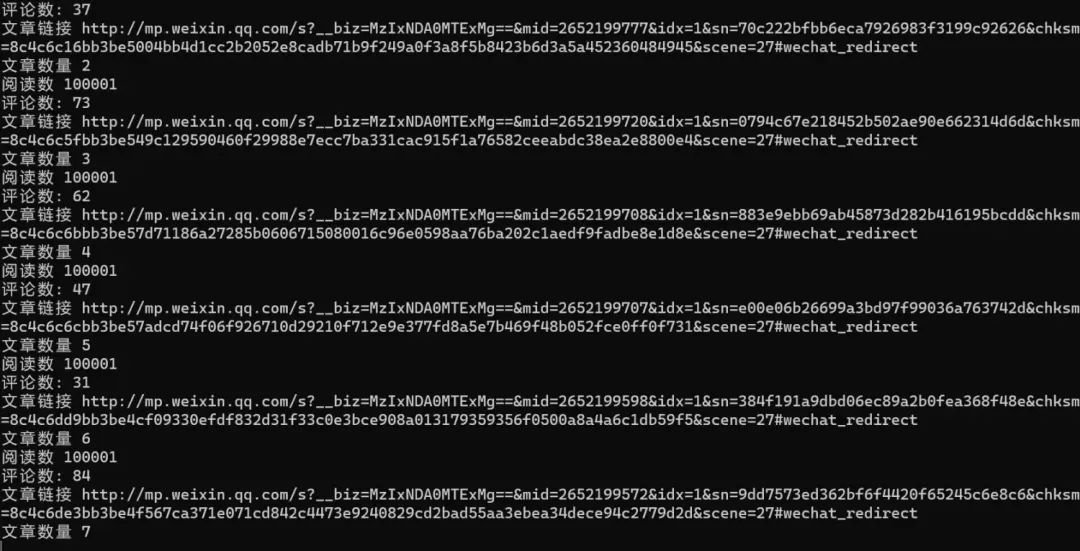

打开wechat_topic_down.exe 输入公众号话题链接即可批量下载,下载效果如图:

我录制了个简单的视频:

我录制了个简单的视频:

音频/视频和文章内容都下载了,有问题加微信 反馈:

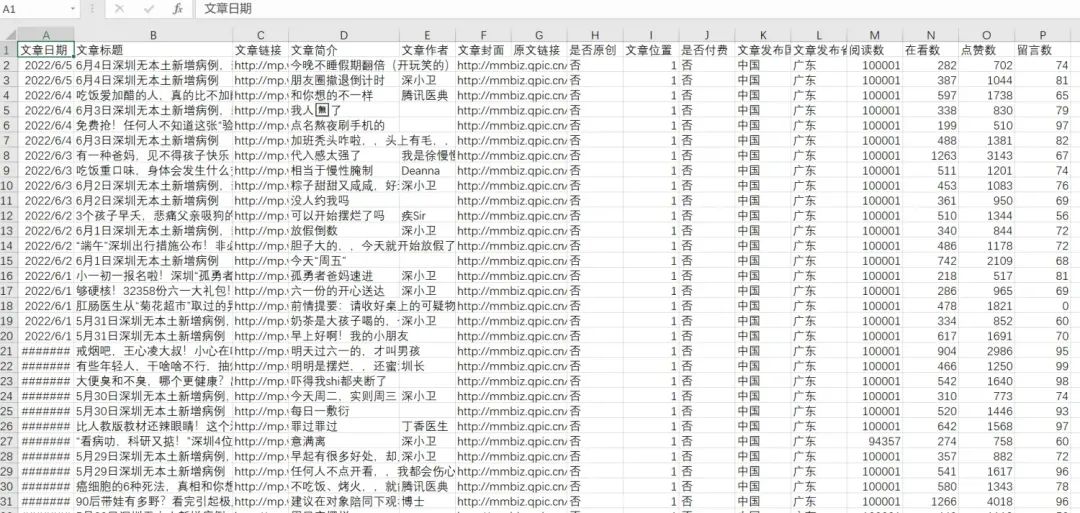

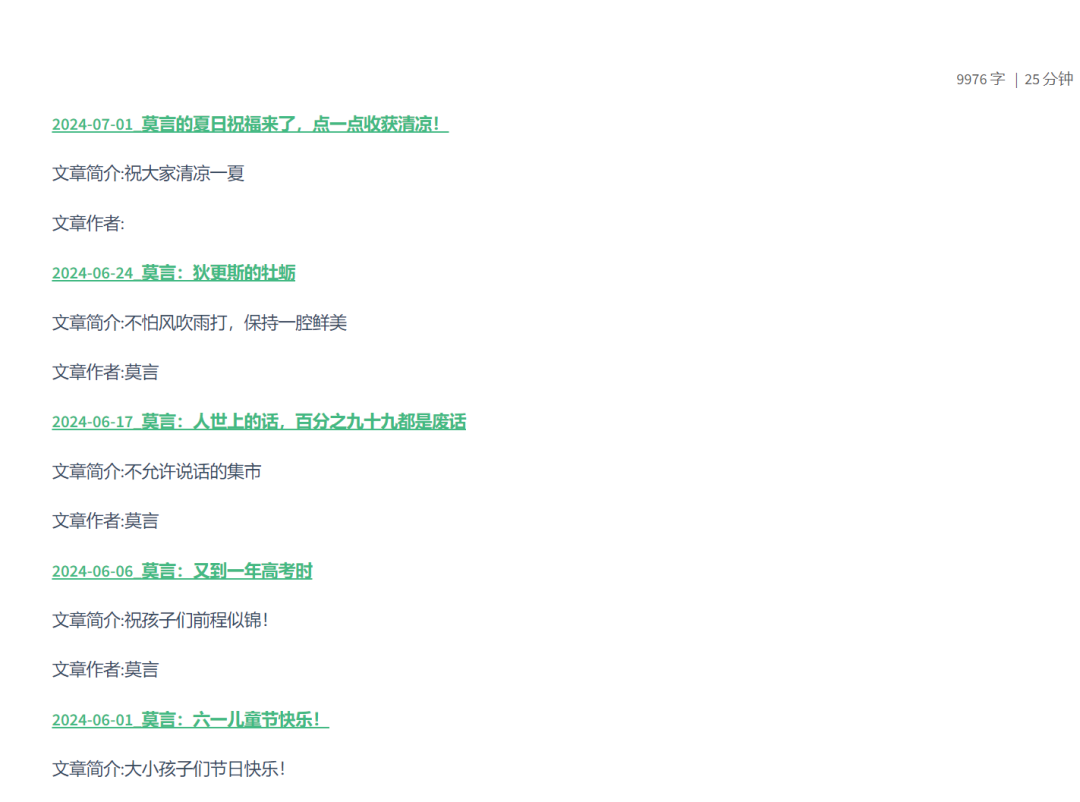

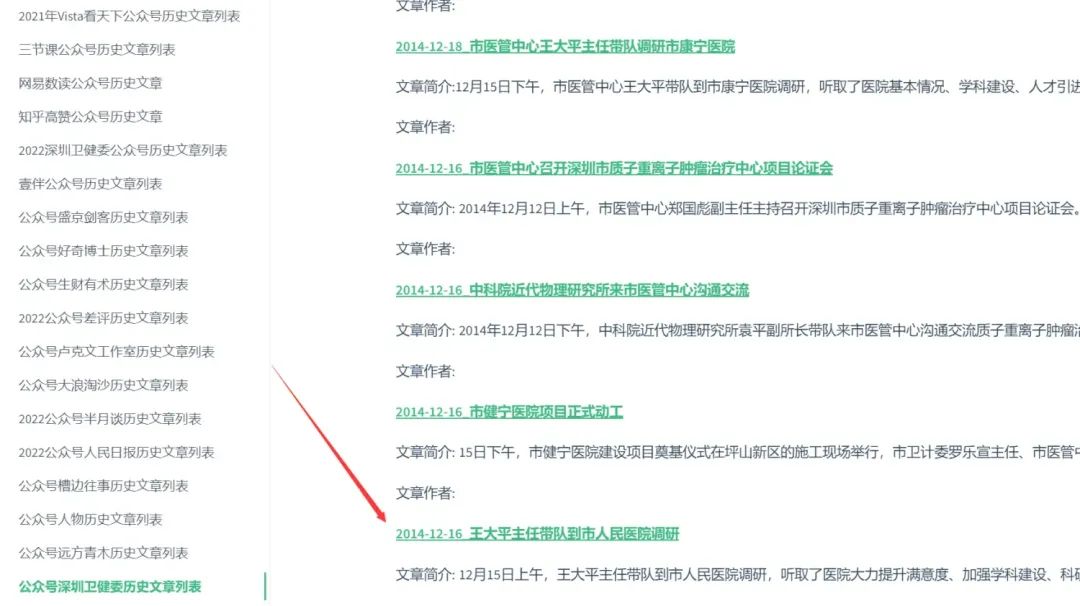

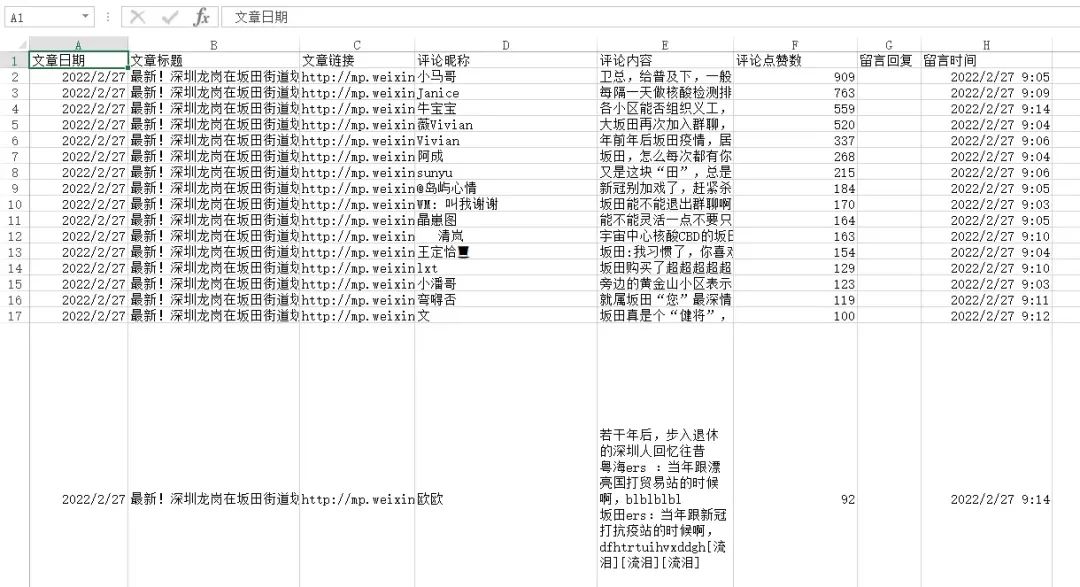

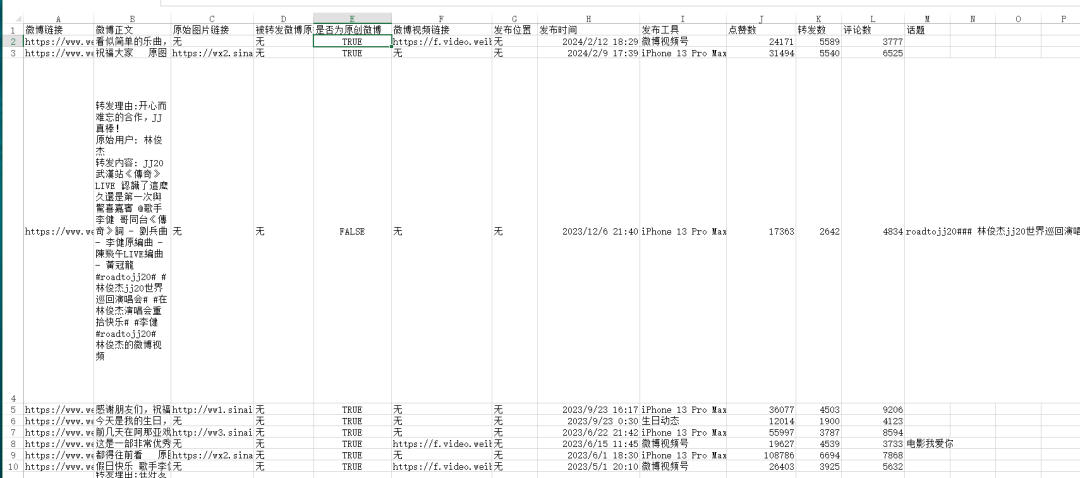

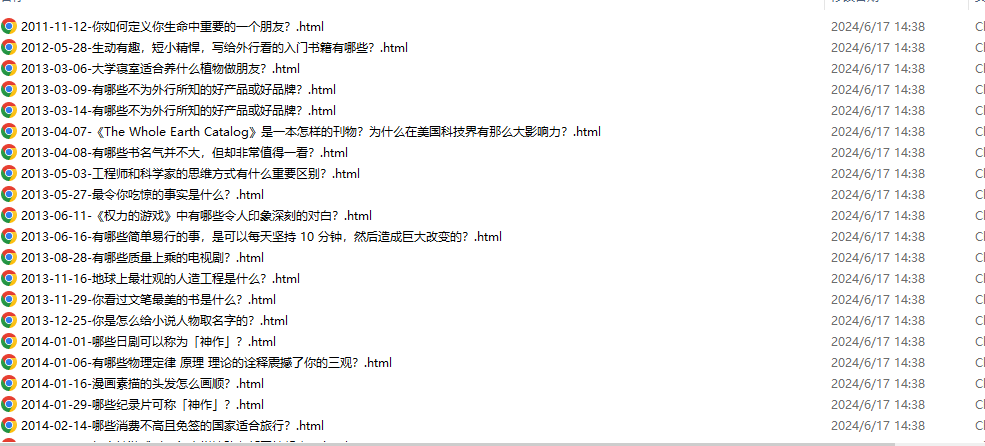

我还写了个脚本批量下载某个公众号的所有历史文章2024批量下载公众号文章内容/话题/图片/封面/视频/音频,导出excel和pdf,文章数据包含阅读数/点赞数/分享数/留言数 ,下载效果如图: 下载生成的excel文章数据包含每篇文章日期,文章标题,文章链接,文章简介,文章作者,文章封面图,是否原创,IP归属地,阅读数,在看数,点赞数,留言数,赞赏次数,文章类型(群发/发布),是否删除,粉丝数,视频数,音频数等,比如深圳卫健委2022年的文章阅读数都是10万+,文章数据分析见文章2022年过去,抓取公众号阅读数点赞数在看数留言数做数据分析, 以深圳卫健委这个号为例 。

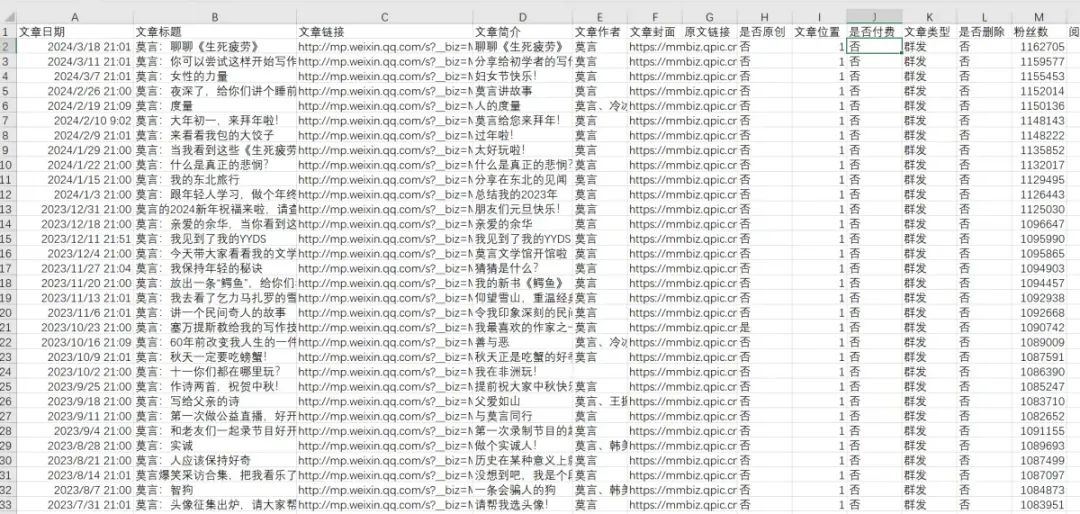

下载生成的excel文章数据包含每篇文章日期,文章标题,文章链接,文章简介,文章作者,文章封面图,是否原创,IP归属地,阅读数,在看数,点赞数,留言数,赞赏次数,文章类型(群发/发布),是否删除,粉丝数,视频数,音频数等,比如深圳卫健委2022年的文章阅读数都是10万+,文章数据分析见文章2022年过去,抓取公众号阅读数点赞数在看数留言数做数据分析, 以深圳卫健委这个号为例 。 不过现在很多号粉丝数很难增长了研究了下莫言的公众号,2023年发布文章166篇,阅读数10万+的文章有120篇,粉丝数过百万 ,抓取了一些公众号大号数据,2024年公众号粉丝数增长很难了,2024年还有哪些百万粉丝公众号?抓取公众号数据分析下 ,比如莫言这种大号一个月也就增长1万左右,2023年3月13日粉丝数1023484,2024年7月1日粉丝数1578445。

不过现在很多号粉丝数很难增长了研究了下莫言的公众号,2023年发布文章166篇,阅读数10万+的文章有120篇,粉丝数过百万 ,抓取了一些公众号大号数据,2024年公众号粉丝数增长很难了,2024年还有哪些百万粉丝公众号?抓取公众号数据分析下 ,比如莫言这种大号一个月也就增长1万左右,2023年3月13日粉丝数1023484,2024年7月1日粉丝数1578445。

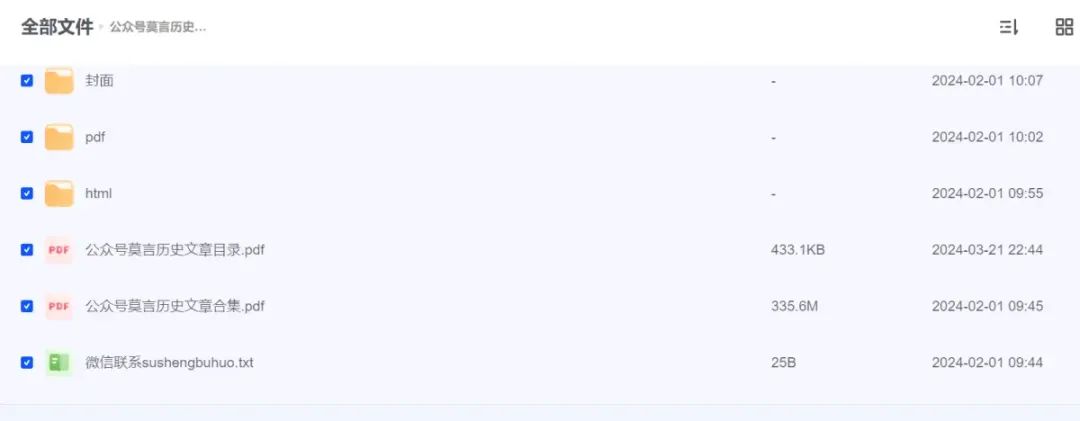

另外为了方便找历史文章2024批量导出公众号所有文章生成目录,这下方便找文章了,部分公众号的历史文章同步到了我的博客https://sushengbuhuo.github.io/blog ,持续更新,不用在手机上翻历史文章了公众号历史文章太多,手机上翻起来太费劲,怎么快速找到某一天的文章? , 为了方便看公众号文章,我搭建了个博客,在线看公众号所有历史文章,想看哪天的文章一秒就能找到 ,比如深圳卫健委从2014到2024发布1万多篇文章,第一篇文章是这个:

每篇文章下的留言内容也可以导出到excel,内容包含文章日期,文章标题文章链接,留言昵称,留言内容,点赞数,回复和留言时间2023批量下载公众号文章内容/话题/图片/封面/视频/音频,导出html和pdf格式,含阅读数/点赞数/在看数/留言数/赞赏数,比如深圳卫健委在2022年的所有文章就有14万多条留言,有需要微信联系我。

除了文章数据还有批量下载文章内容,这里以莫言老师的公众号为例,下载的所有历史文章内容和音频,视频 :

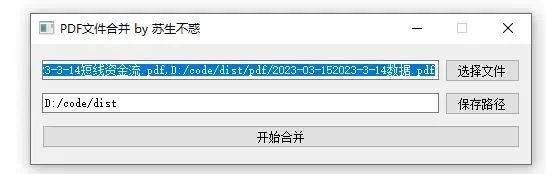

最后将下载的所有文章合并成一个pdf文件 ,包含文章留言和书签,点击左侧书签跳转到对应文章,效果见网盘地址 https://pan.quark.cn/s/afa15a7b027b ,里面包含了文章内容pdf和文章数据excel: 这次文章下的留言增加了留言时间。

这次文章下的留言增加了留言时间。

微博

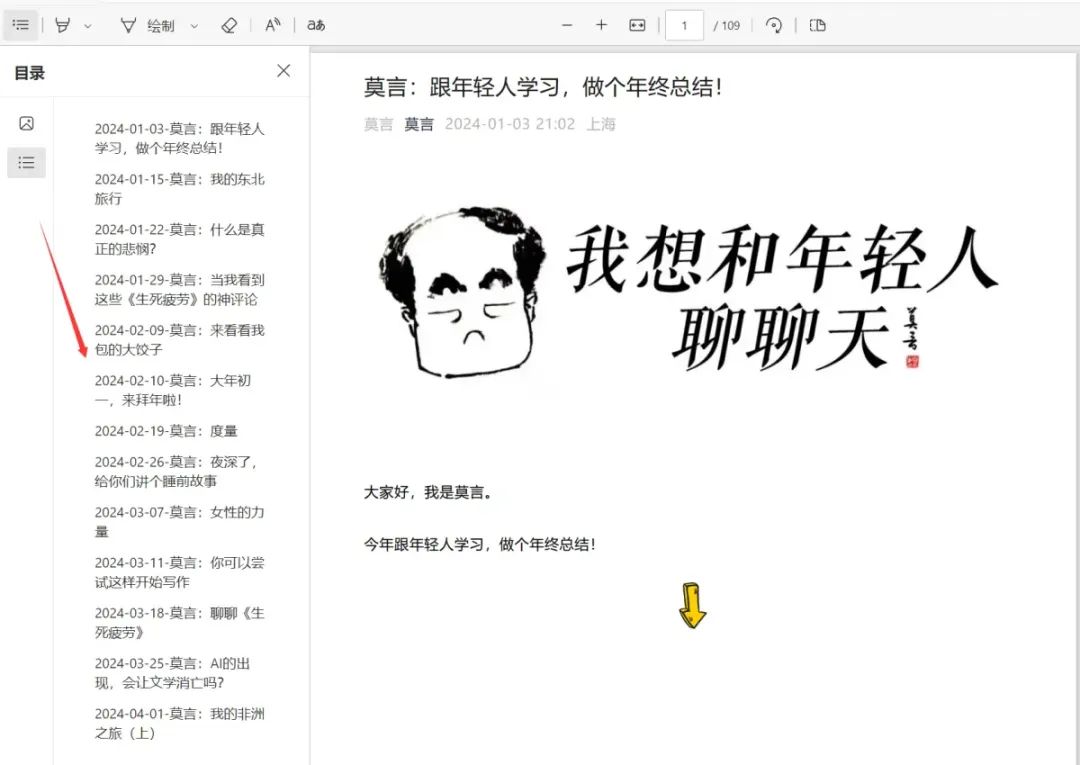

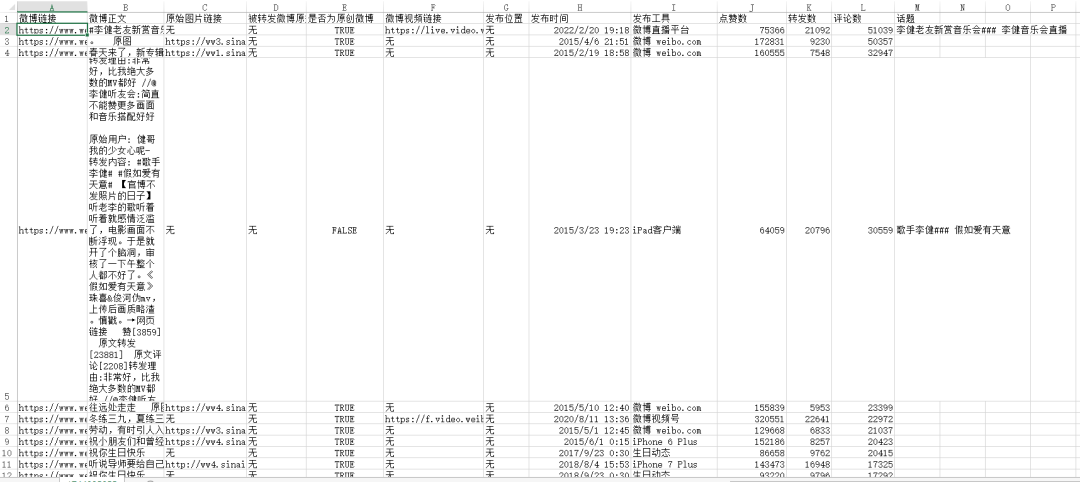

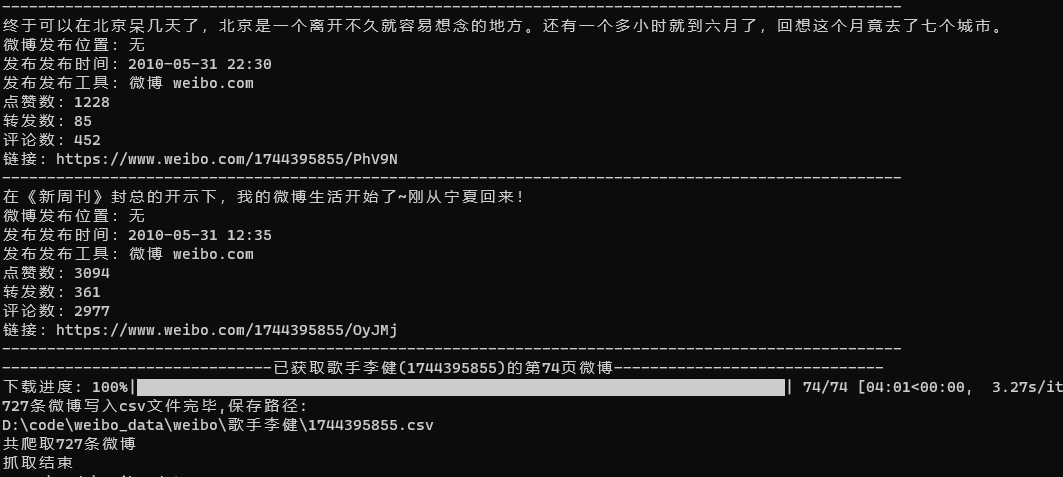

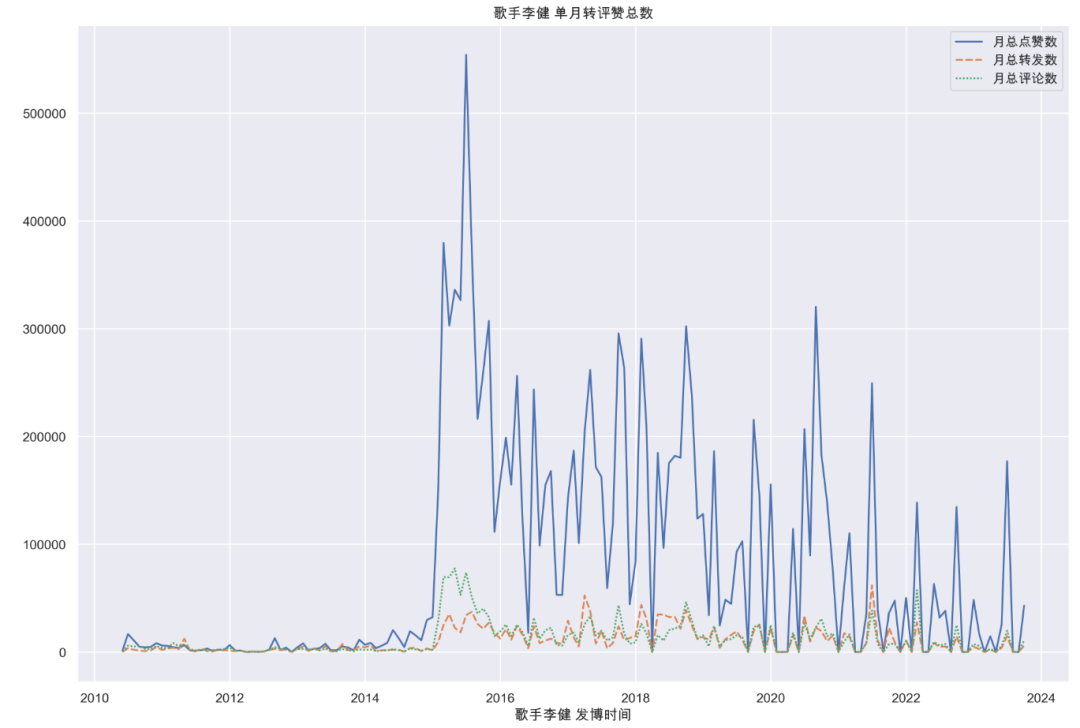

以这个号为例https://weibo.com/n/歌手李健,共抓取727条微博,导出的excel微博数据包含微博链接,微博正文,原始图片链接,被转发微博原始图片链接,是否为原创微博,微博视频链接,发布位置,发布时间,发布工具,点赞数,转发数,评论数,话题等苏生不惑出品:2024 批量下载微博内容/图片/视频/评论/转发,导出excel和pdf

第一条微博发布于2010年5月31 https://www.weibo.com/1744395855/OyJMj

第一条微博发布于2010年5月31 https://www.weibo.com/1744395855/OyJMj

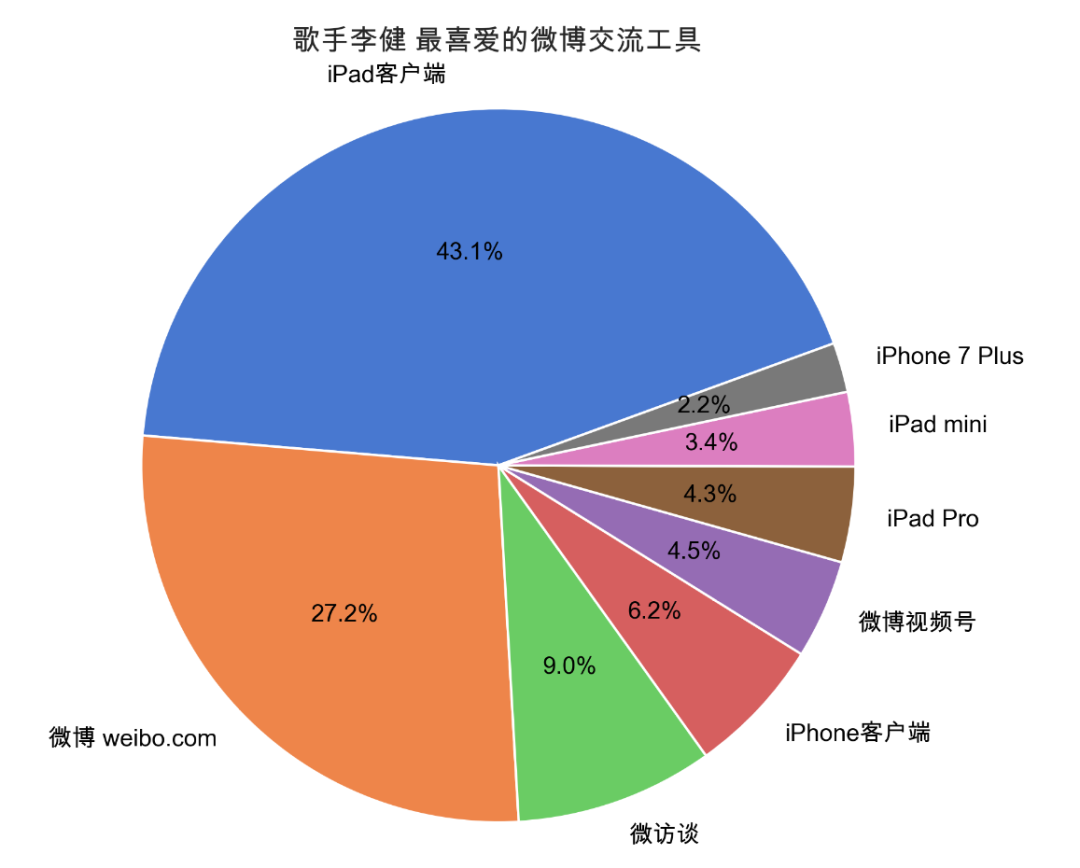

再分析下微博发布工具比例图:

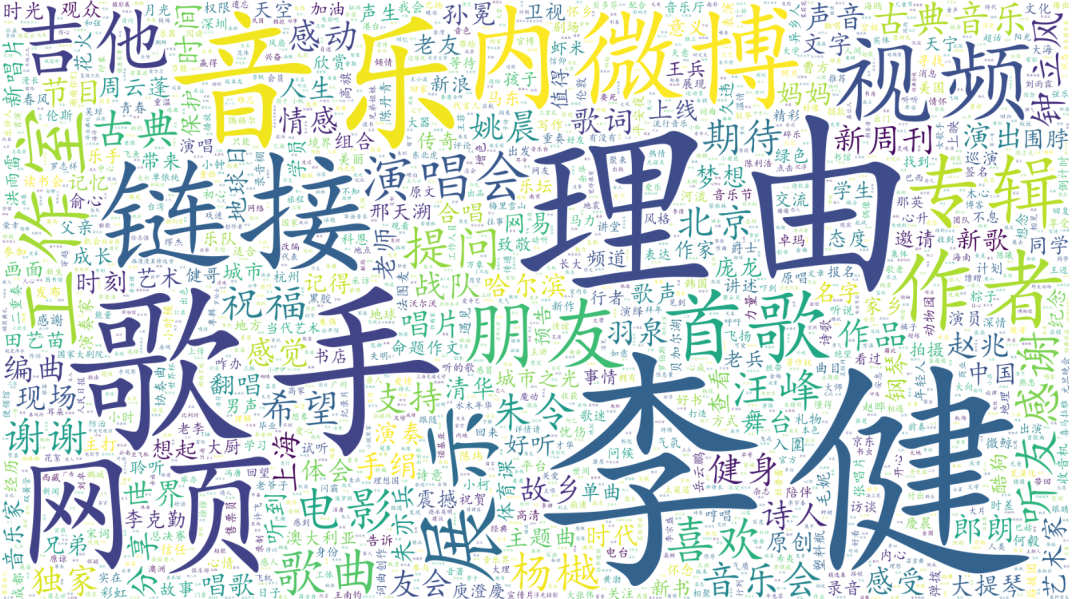

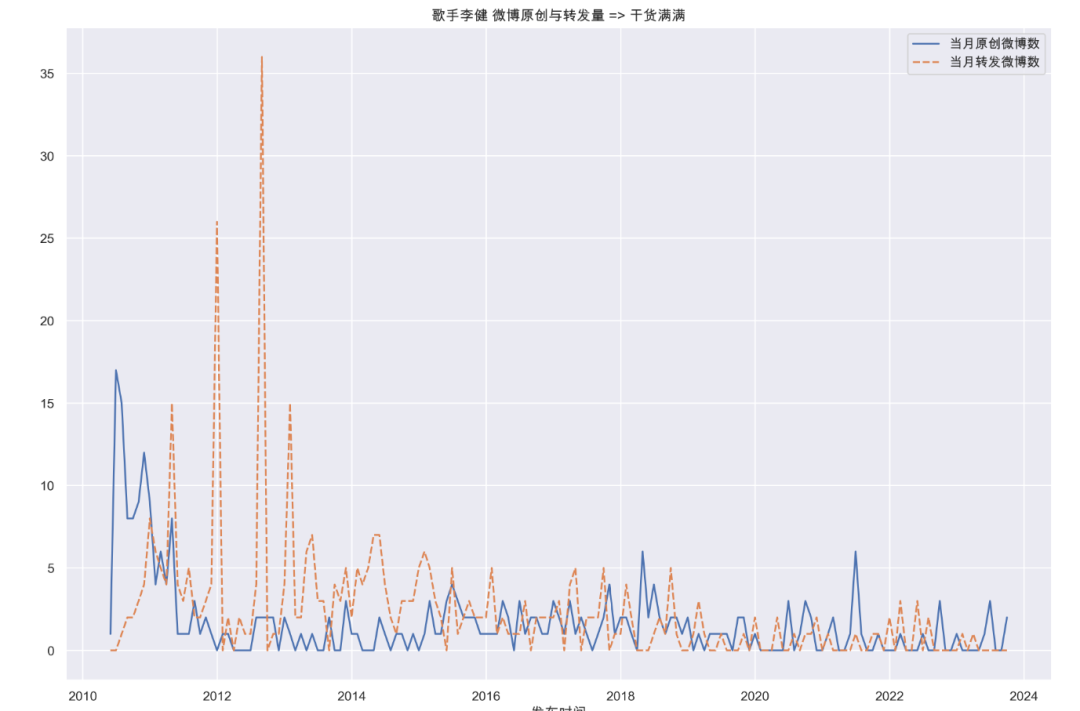

微博内容词云图: 原创微博与转发数据分布图:

原创微博与转发数据分布图: 转发评论点赞数据分布图:

转发评论点赞数据分布图:

下载的微博内容保存到word和txt,无水印图片,视频:

word微博内容:

所有微博内容导出pdf,大小 40MB。

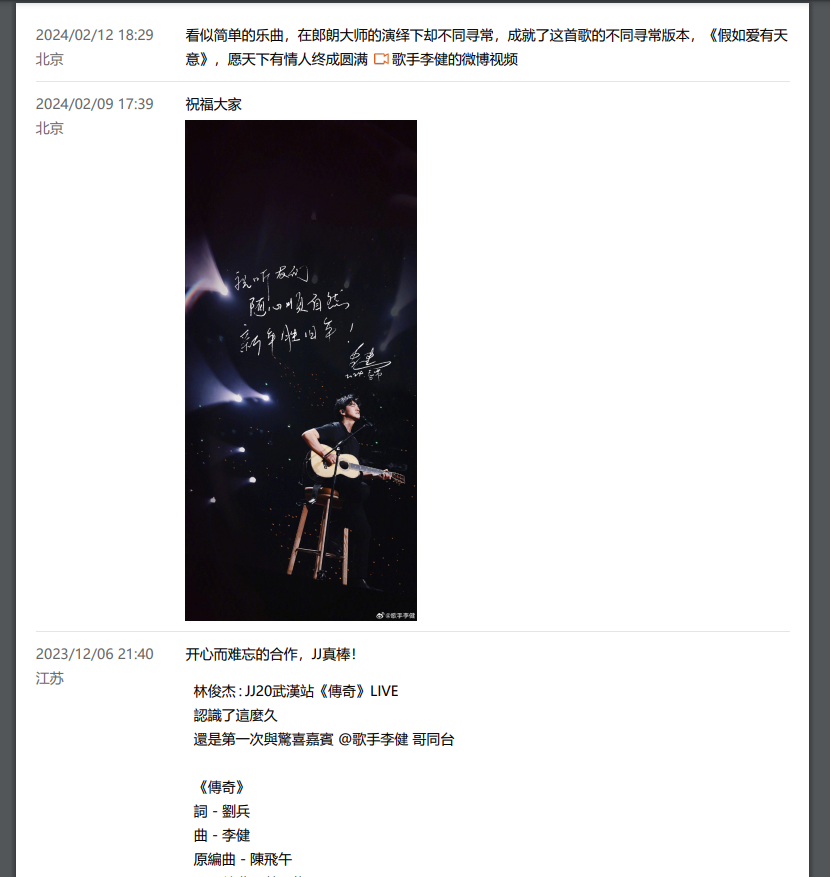

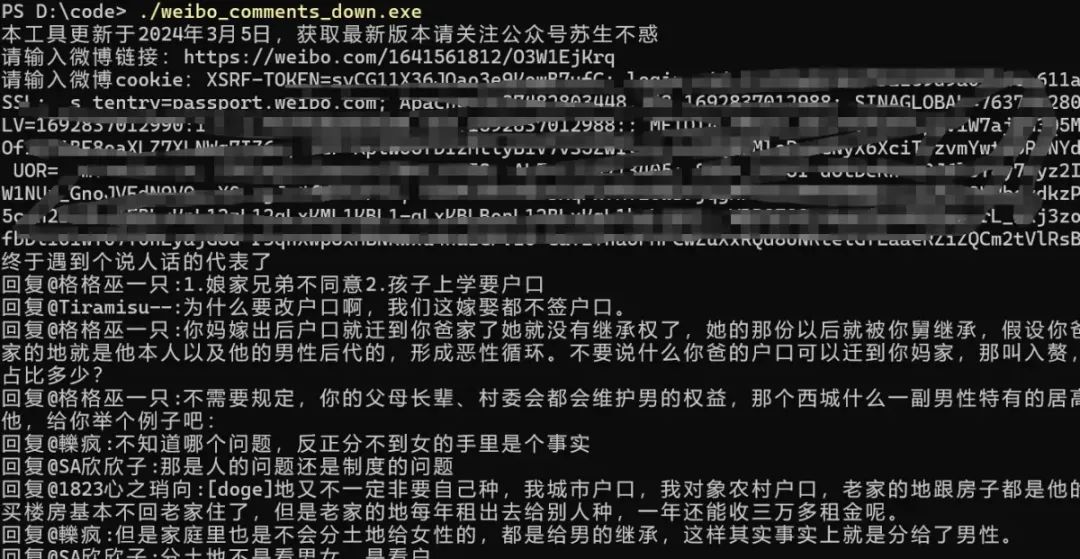

然后是批量下载微博评论2024 批量下载微博内容/图片/视频/评论/转发数据,导出excel和pdf,工具下载地址在公众号后台对话框回复 ,打开工具输入微博链接https://weibo.com/1641561812/O3W1EjKrq和网页版微博cookie就行:

然后是批量下载微博评论2024 批量下载微博内容/图片/视频/评论/转发数据,导出excel和pdf,工具下载地址在公众号后台对话框回复 ,打开工具输入微博链接https://weibo.com/1641561812/O3W1EjKrq和网页版微博cookie就行:

我录制了个简单的视频:

我录制了个简单的视频:

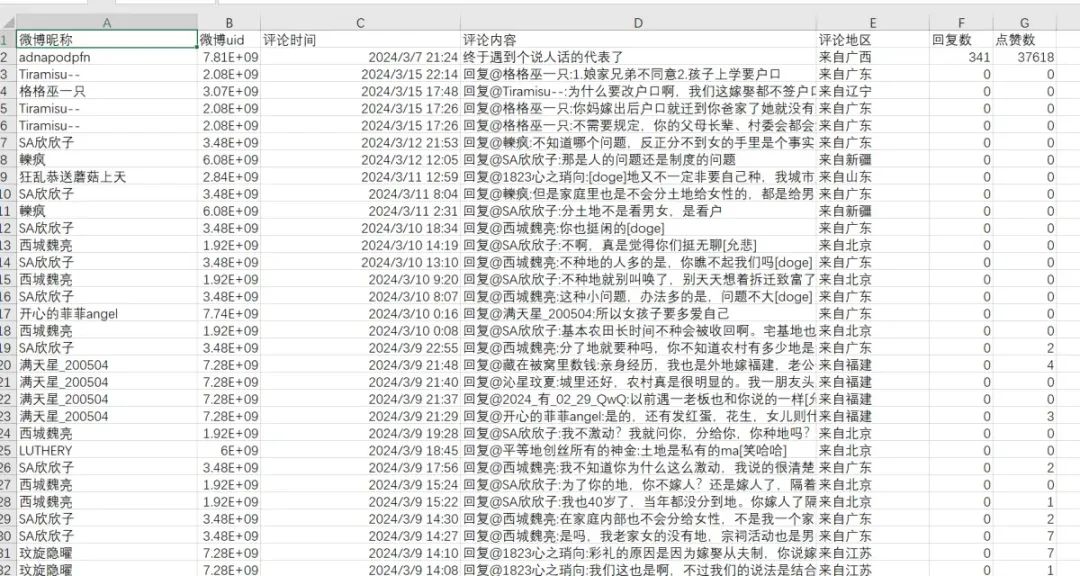

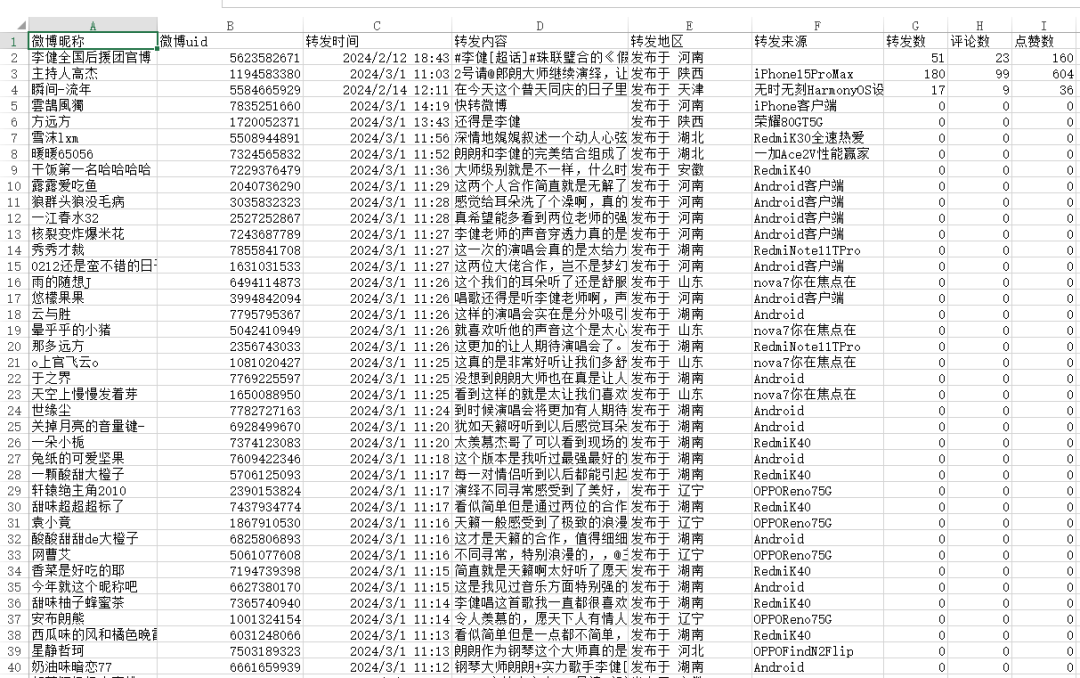

导出的excel数据包含微博昵称,微博uid,评论时间,评论内容,评论地区,回复数,点赞数等。

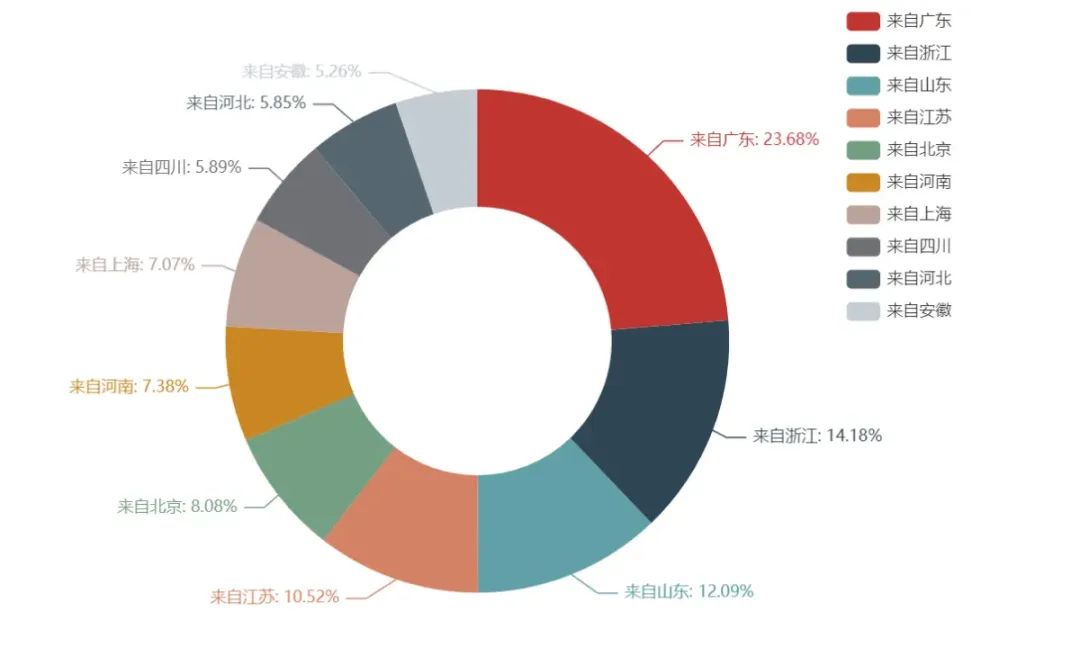

对excel文件分析评论IP地址分布图:

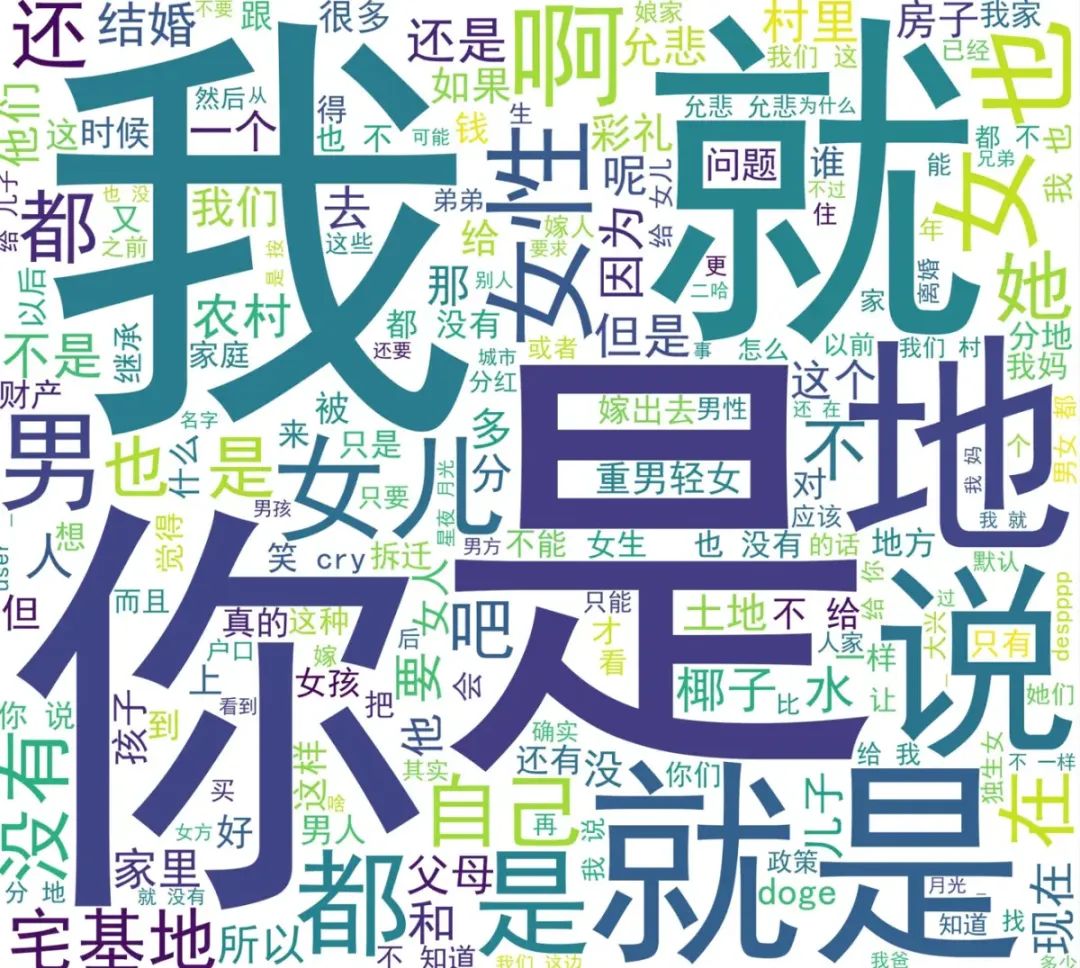

对excel文件分析评论IP地址分布图: 对excel文件分析评论内容生成的词云图:

对excel文件分析评论内容生成的词云图:

还有批量下载微博转发内容,导出的excel数据包含微博昵称,微博uid,转发时间,转发内容,转发地区,转发来源,转发数,评论数,点赞数,比如https://m.weibo.cn/status/5000660202553386这条微博有5000多条转发微博:

还有批量下载微博转发内容,导出的excel数据包含微博昵称,微博uid,转发时间,转发内容,转发地区,转发来源,转发数,评论数,点赞数,比如https://m.weibo.cn/status/5000660202553386这条微博有5000多条转发微博:

知乎

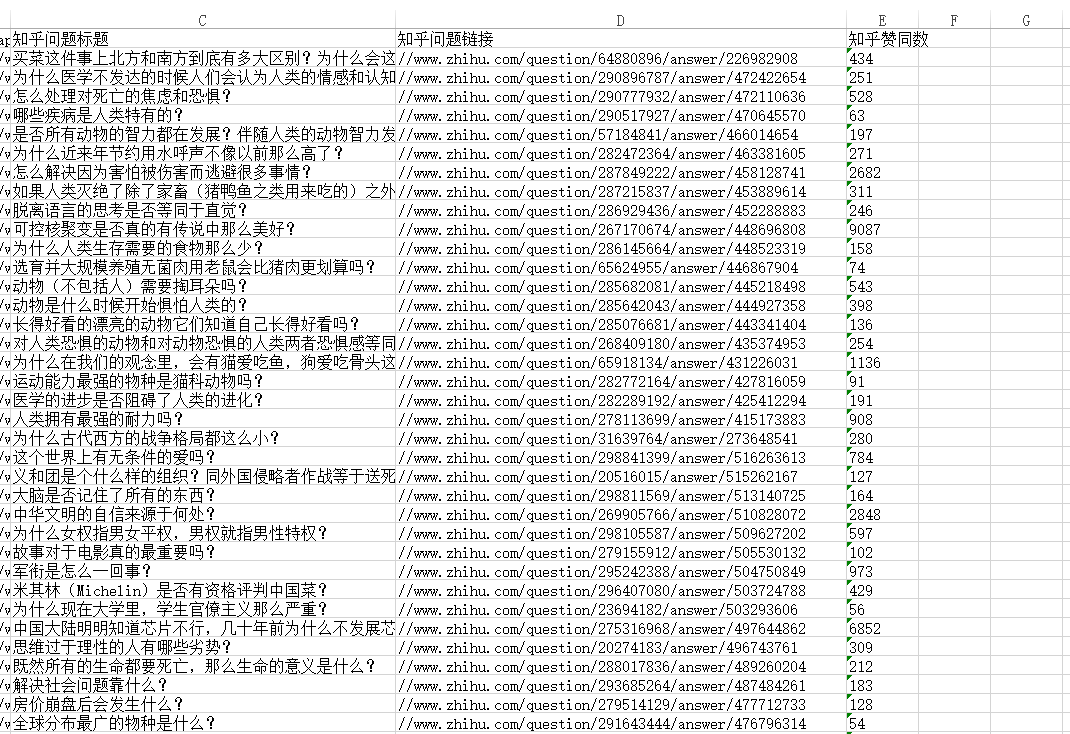

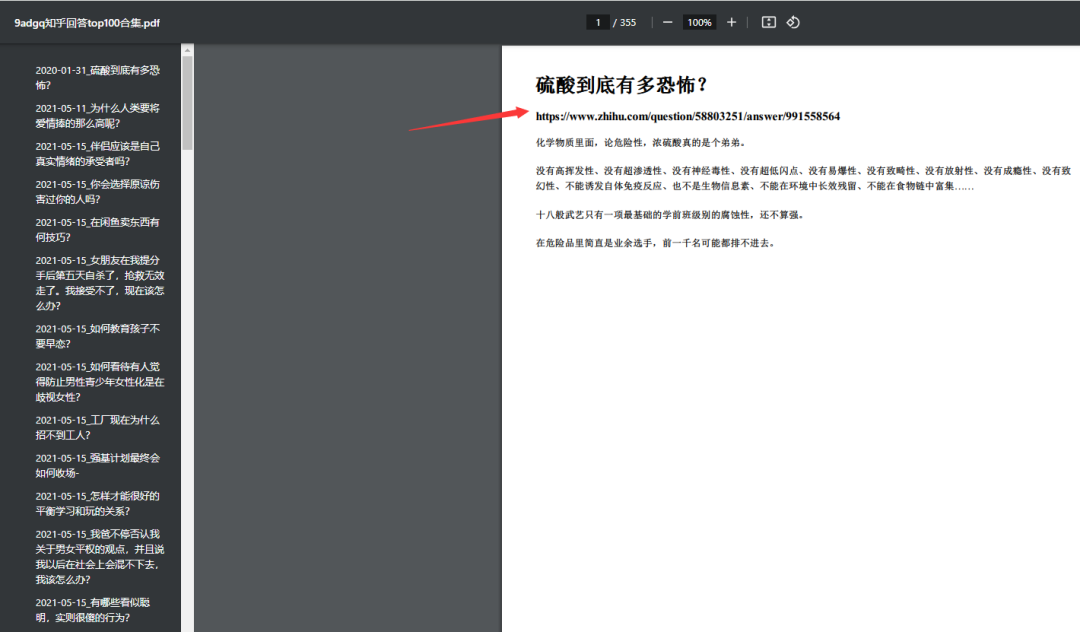

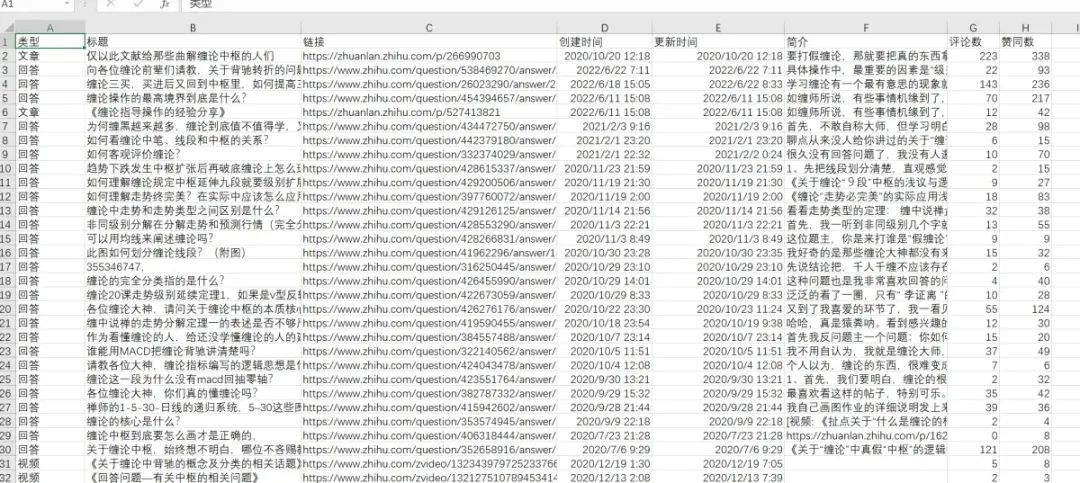

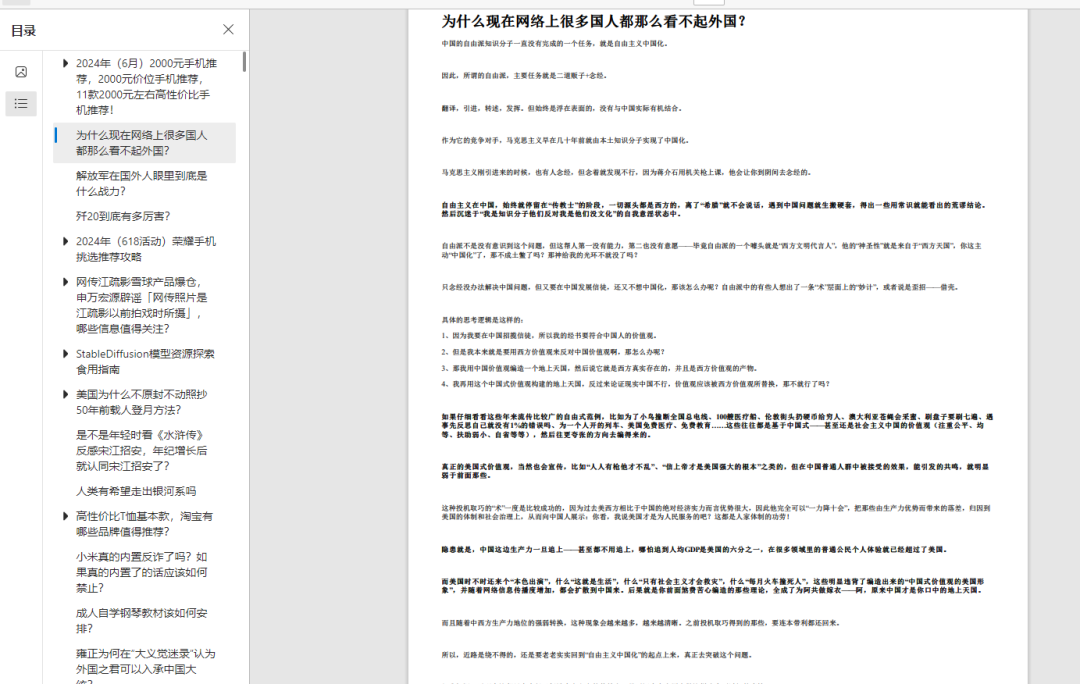

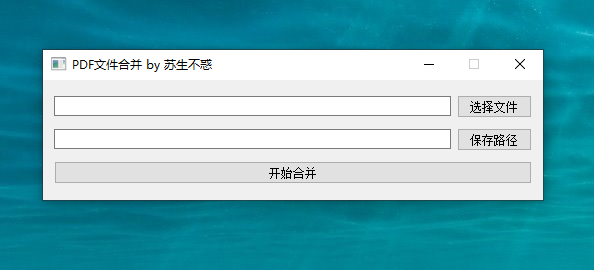

之前分享过文章2024 批量下载知乎回答/文章/想法/专栏/视频/收藏夹导出 excel 和 pdf ,导出的所有知乎回答excel数据包含所有知乎回答问题标题,链接,赞同数和评论数。 将所有知乎回答pdf合成一个pdf文件,大小近300MB,网盘地址 https://pan.quark.cn/s/8522433ad346

将所有知乎回答pdf合成一个pdf文件,大小近300MB,网盘地址 https://pan.quark.cn/s/8522433ad346

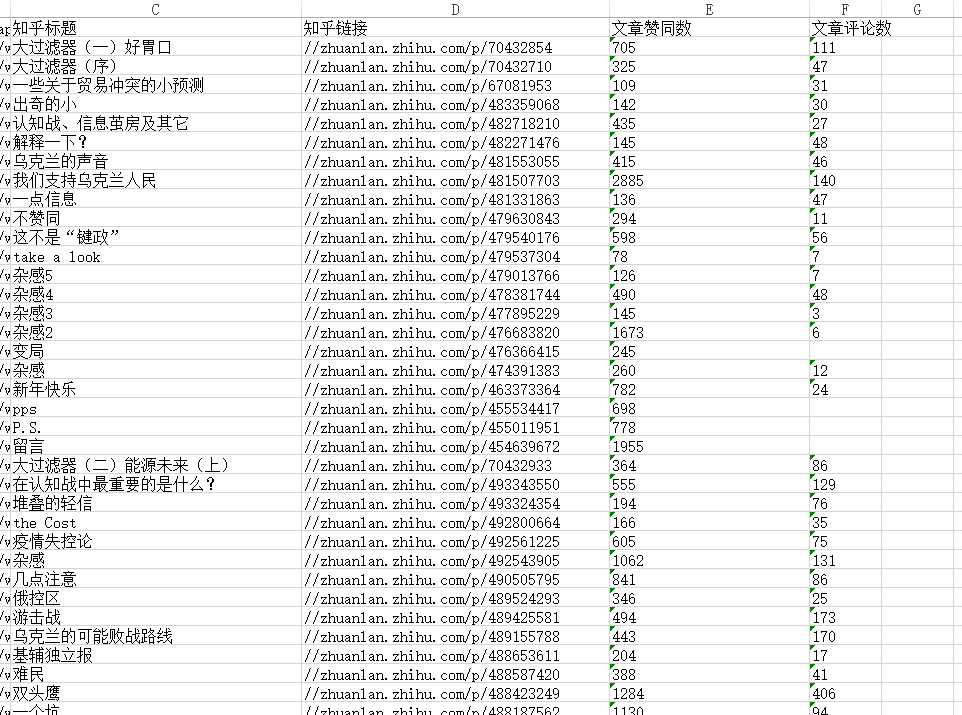

导出的所有知乎文章excel数据包含知乎文章标题,链接,评论数和赞同数。 将所有知乎文章合成一个pdf,大小10MB:

将所有知乎文章合成一个pdf,大小10MB:

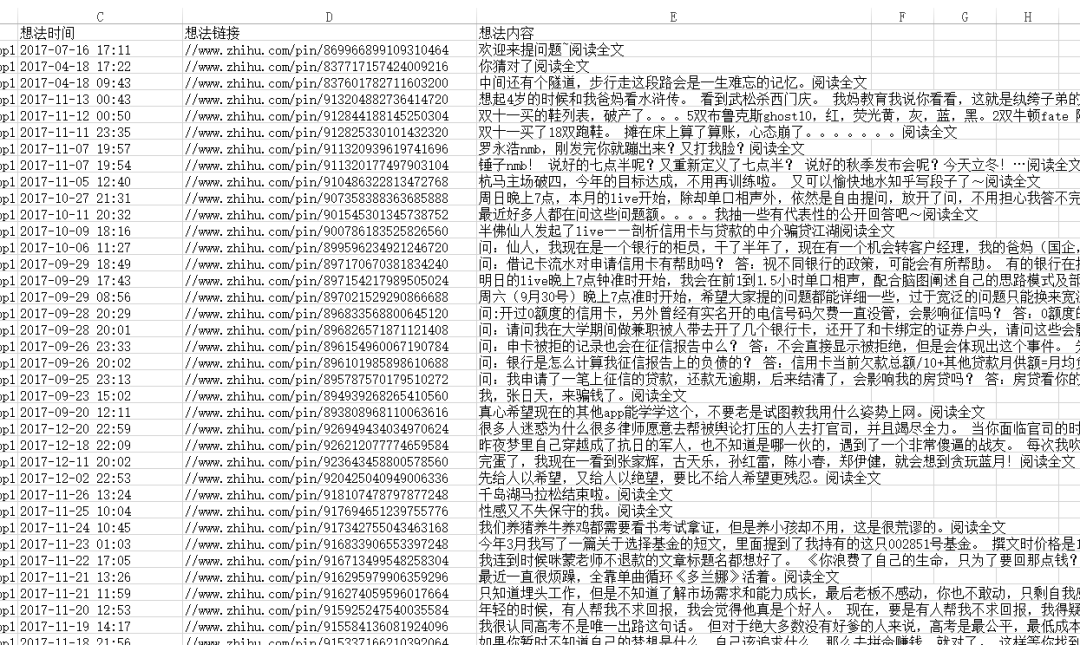

导出的所有知乎想法excel数据包含想法发布时间,想法链接,想法内容。

导出的所有知乎想法excel数据包含想法发布时间,想法链接,想法内容。

将所有知乎想法合成一个pdf文件,大小11MB。

将所有知乎想法合成一个pdf文件,大小11MB。

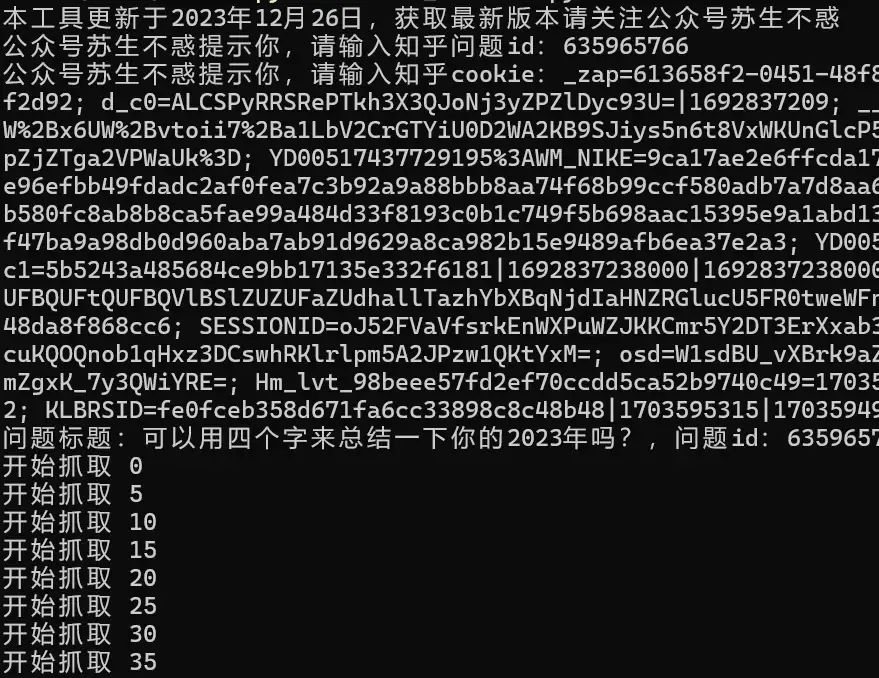

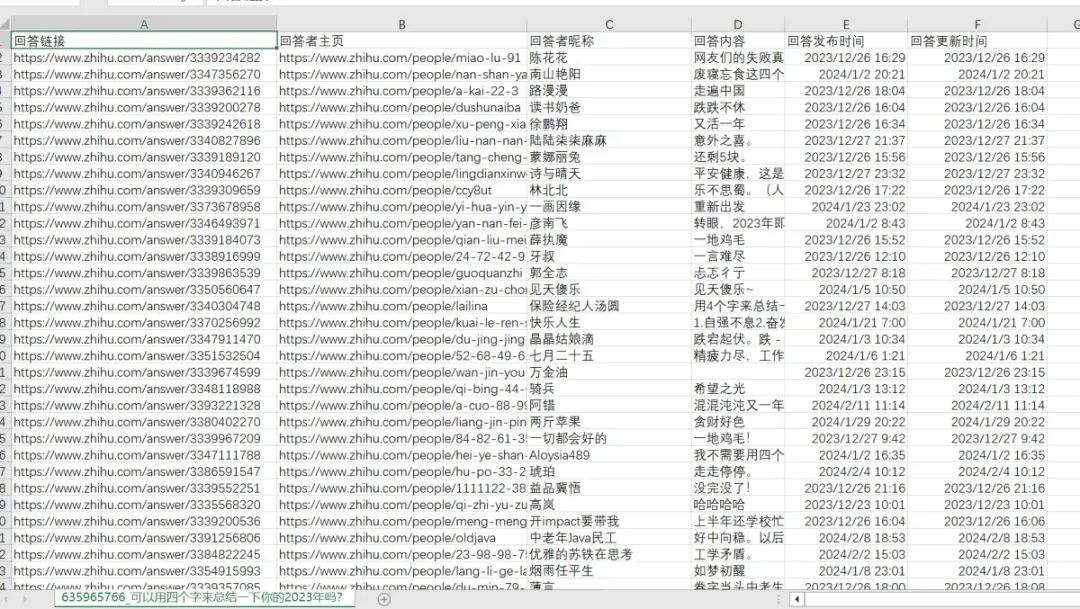

还有批量下载知乎问题下的回答 https://www.zhihu.com/question/635965766 ,输入知乎问题id和cookie就行,如何获取cookie见我之前文章 总有人问我 cookie 到底是什么?

导出的excel包含每个回答的回答链接,回答作者,回答内容,回答时间和回答更新时间,图片太多就不下载了。

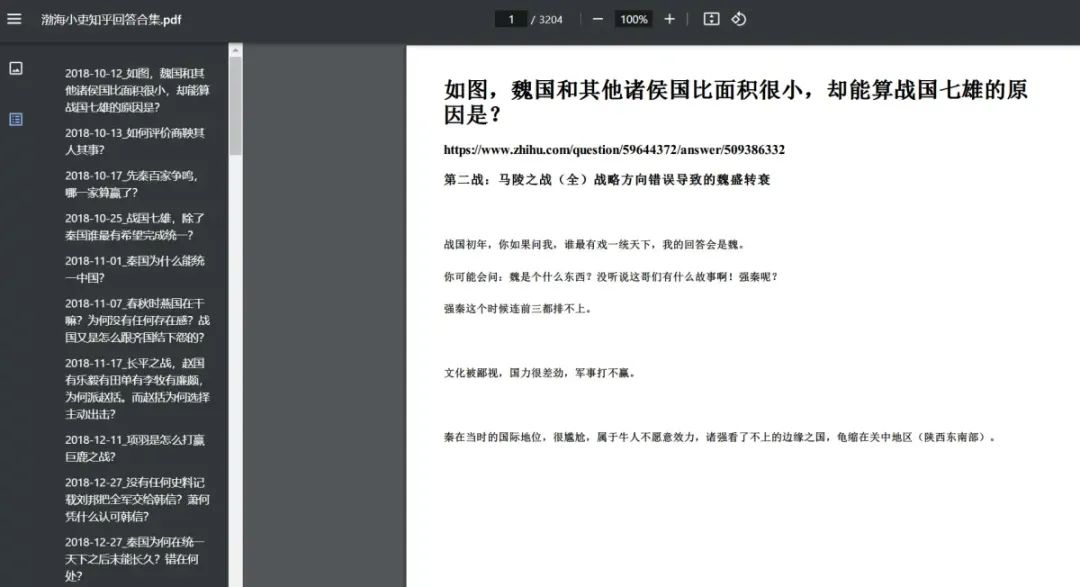

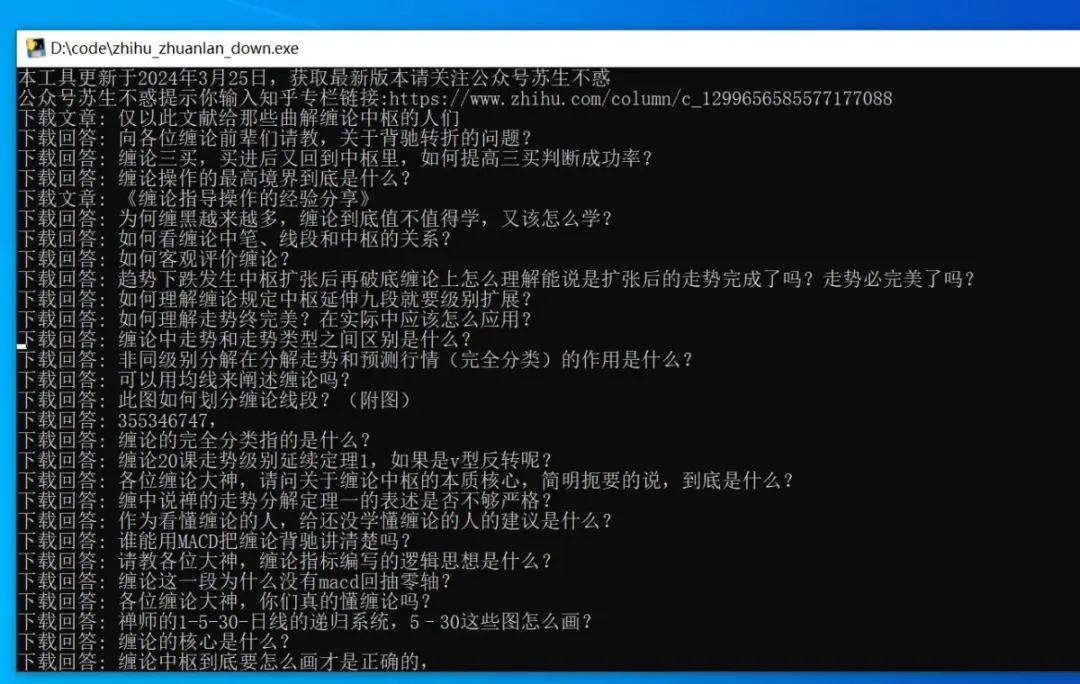

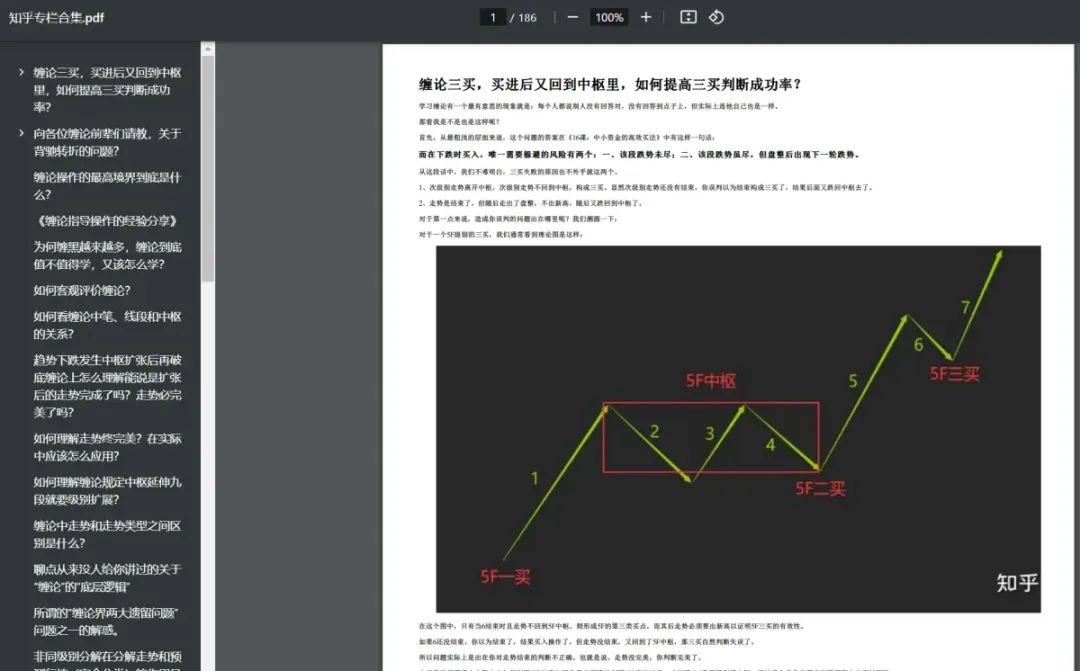

还有批量下载知乎专栏2024批量下载知乎回答文章想法专栏视频,公众号文章内容图片封面视频音频,微博内容图片视频评论转发数据,导出excel和pdf ,比如这个专栏https://www.zhihu.com/column/c_1299656585577177088 ,里面包含了回答,文章和视频,打开工具输入专栏地址即可批量下载,下载地址在公众号后台对话框回复  我录制了个简单的视频:

我录制了个简单的视频:

下载的excel数据包含类型,标题,链接,创建时间,更新时间,简介,评论数和赞同数。 所有文章生成的合集pdf:

所有文章生成的合集pdf: 还有文章html和视频,有问题可以加微信

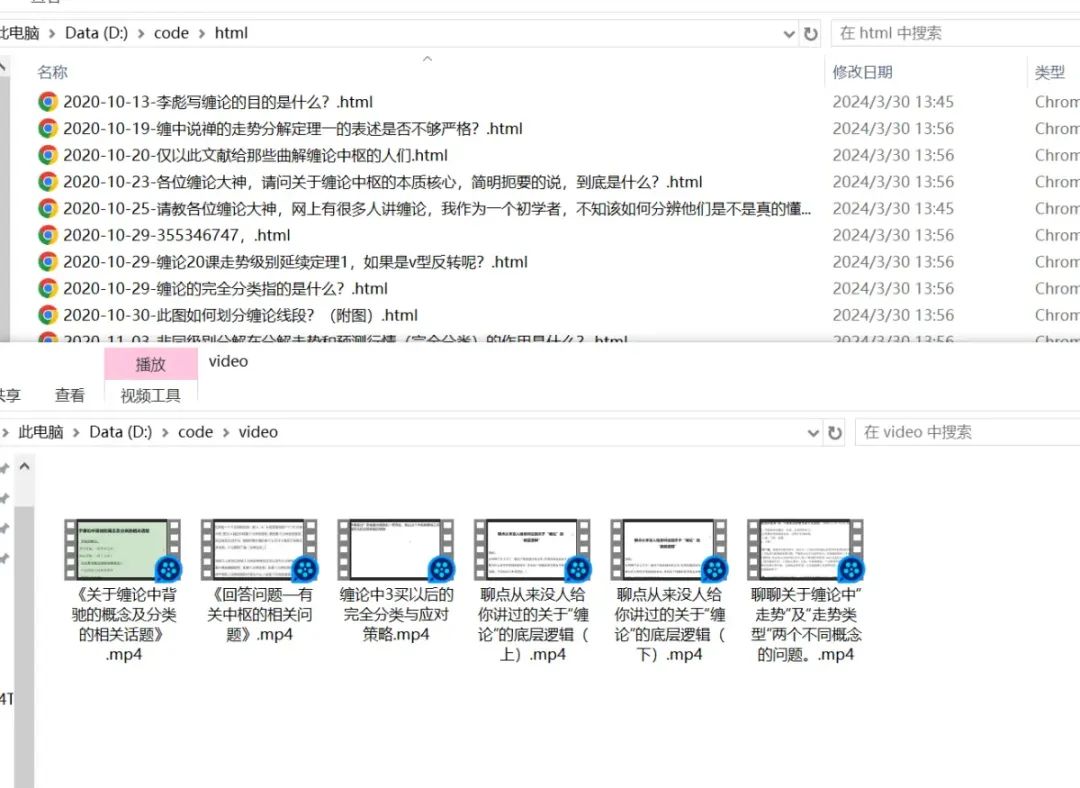

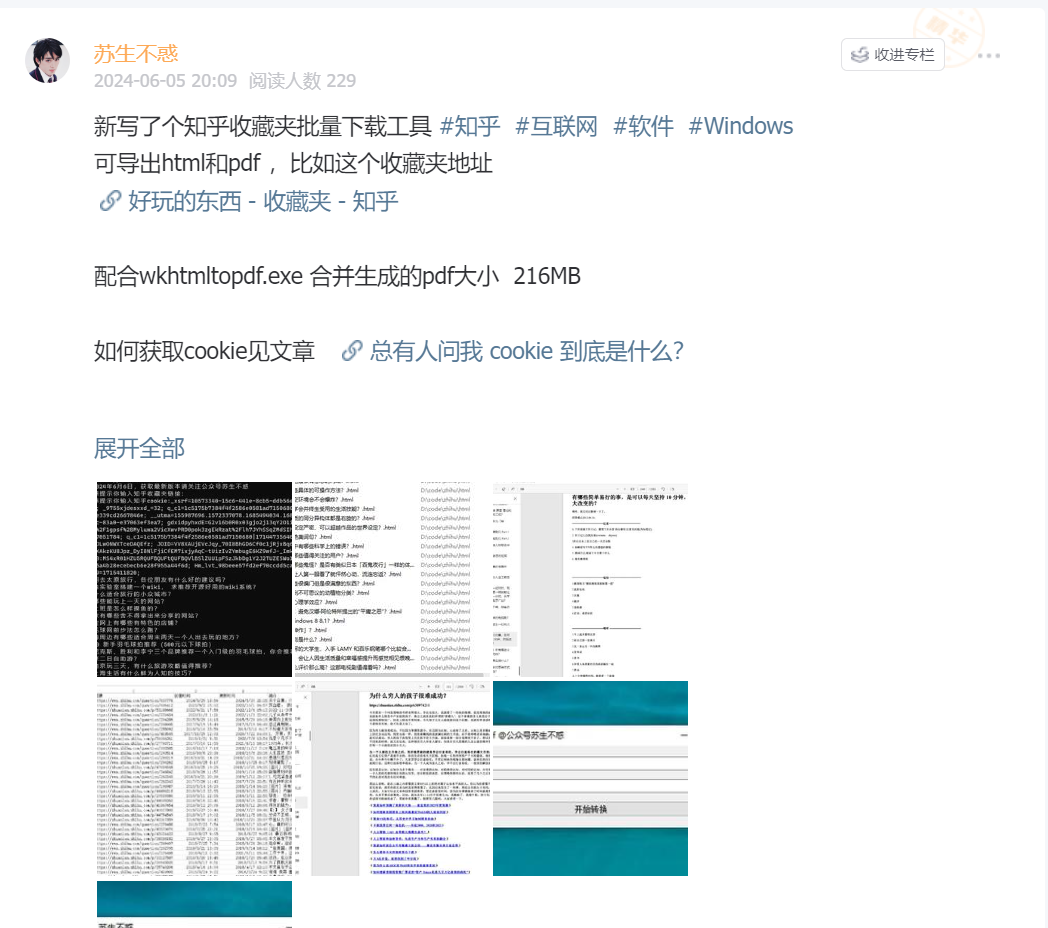

还有文章html和视频,有问题可以加微信  以及知乎收藏夹批量下载, 工具发布在我的知识星球 https://t.zsxq.com/qWLTU ,欢迎加入我的知识星球 加入我的知识星球

以及知乎收藏夹批量下载, 工具发布在我的知识星球 https://t.zsxq.com/qWLTU ,欢迎加入我的知识星球 加入我的知识星球

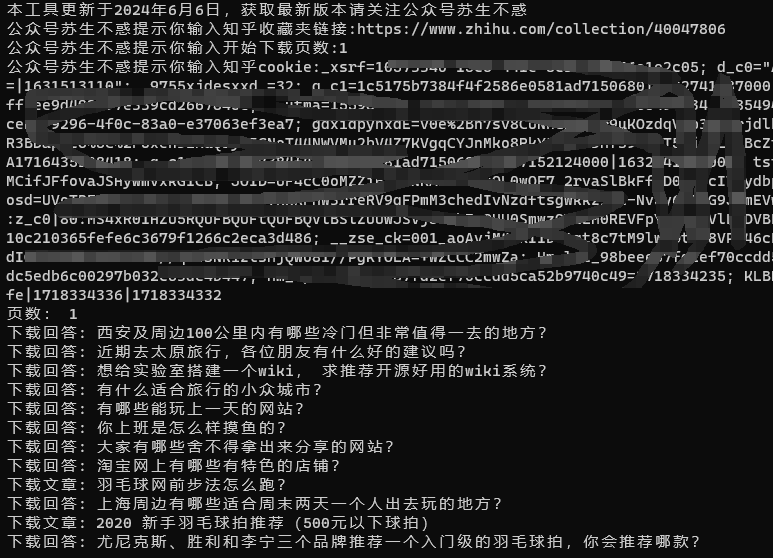

打开工具输入知乎收藏夹地址https://www.zhihu.com/collection/40047806,页数,cookie 总有人问我 cookie 到底是什么? :

打开工具输入知乎收藏夹地址https://www.zhihu.com/collection/40047806,页数,cookie 总有人问我 cookie 到底是什么? :

默认下载500篇回答,视频,文章,如果要继续下,修改页数再次下载。

默认下载500篇回答,视频,文章,如果要继续下,修改页数再次下载。 下载的html文件在zhihu目录。

下载的html文件在zhihu目录。 下载的视频在video目录。

下载的视频在video目录。

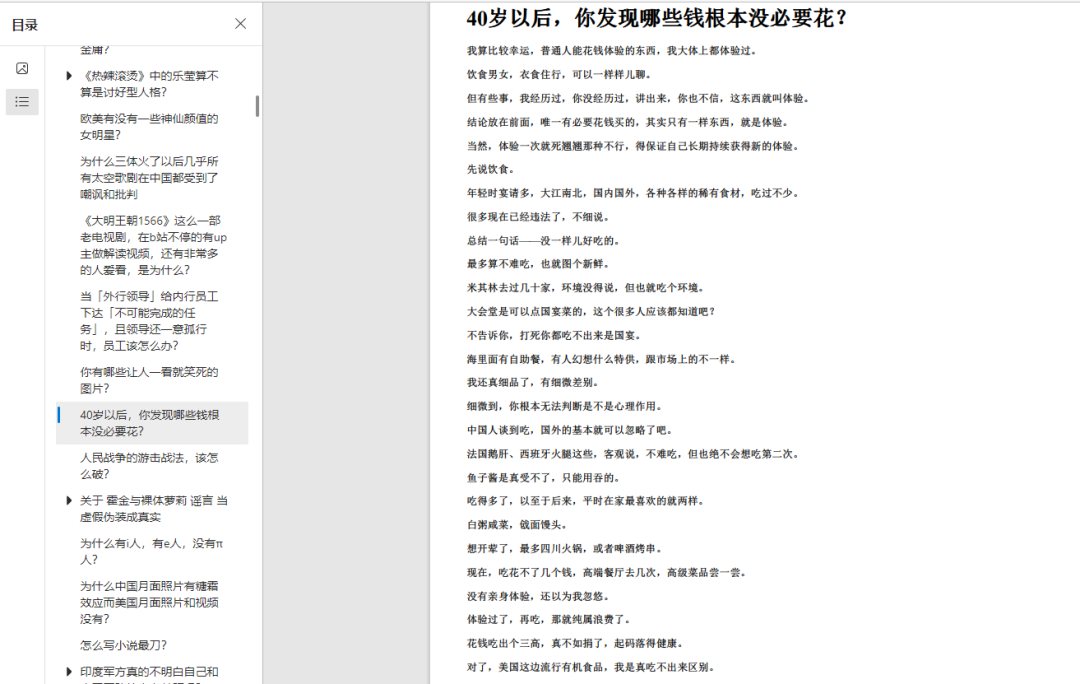

下载完成后合并转换生成的pdf文件200MB ,它依赖wkhtmltopdf ,将wkhtmltopdf.exe加入环境变量。

点击左侧标题书签可以跳转到对应内容。

点击左侧标题书签可以跳转到对应内容。

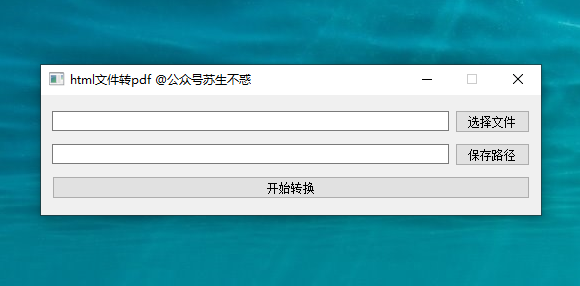

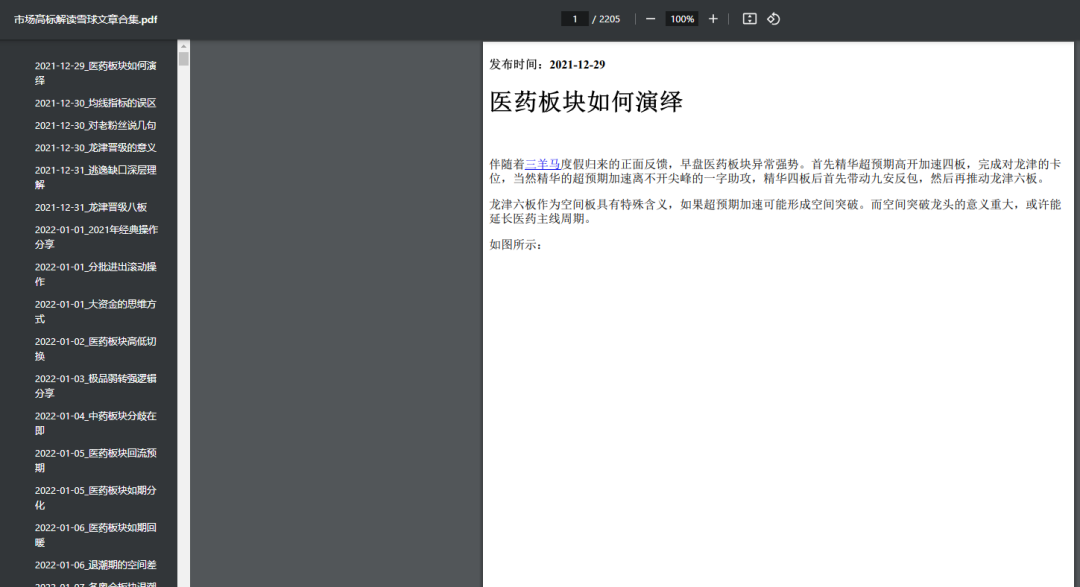

如果转换pdf失败可以用我开发的html2pdf批量转换html为pdf。

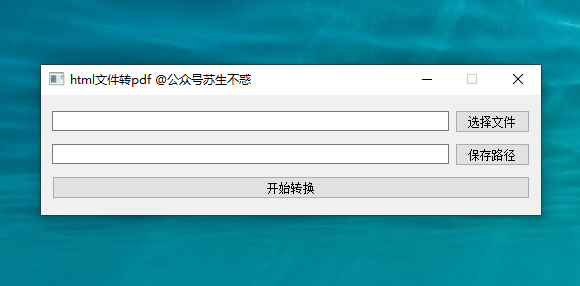

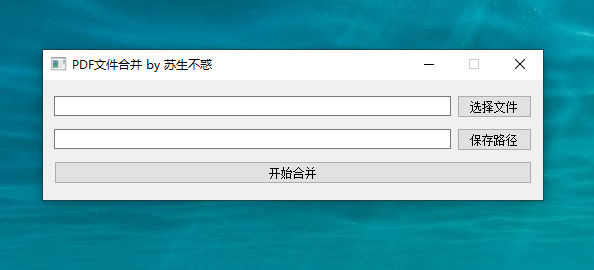

再用pdf_merge将pdf文件合并成一个文件。

再用pdf_merge将pdf文件合并成一个文件。

抓取的收藏夹excel数据包含类型(回答,文章,视频),标题,链接,创建时间,更新时间,简介,评论数,赞同数,页数。

雪球

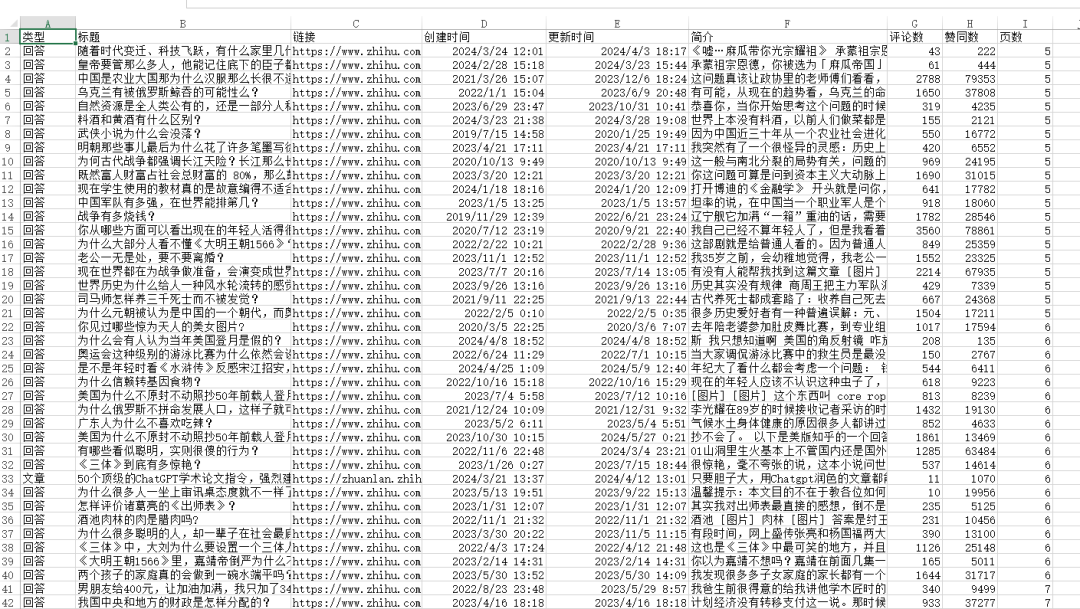

打开软件提示输入雪球主页地址和浏览器cookie2024 批量下载雪球/东方财富文章导出excel和pdf,比如爱在冰川这个号https://xueqiu.com/u/4104161666,cookie 在浏览器控制台获取: 下载效果如图:

下载效果如图:

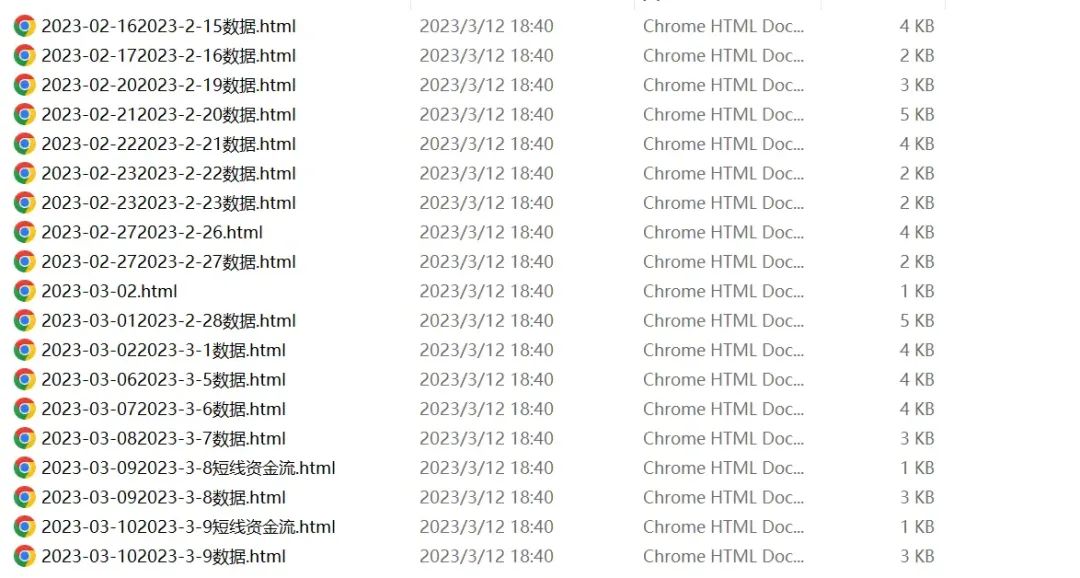

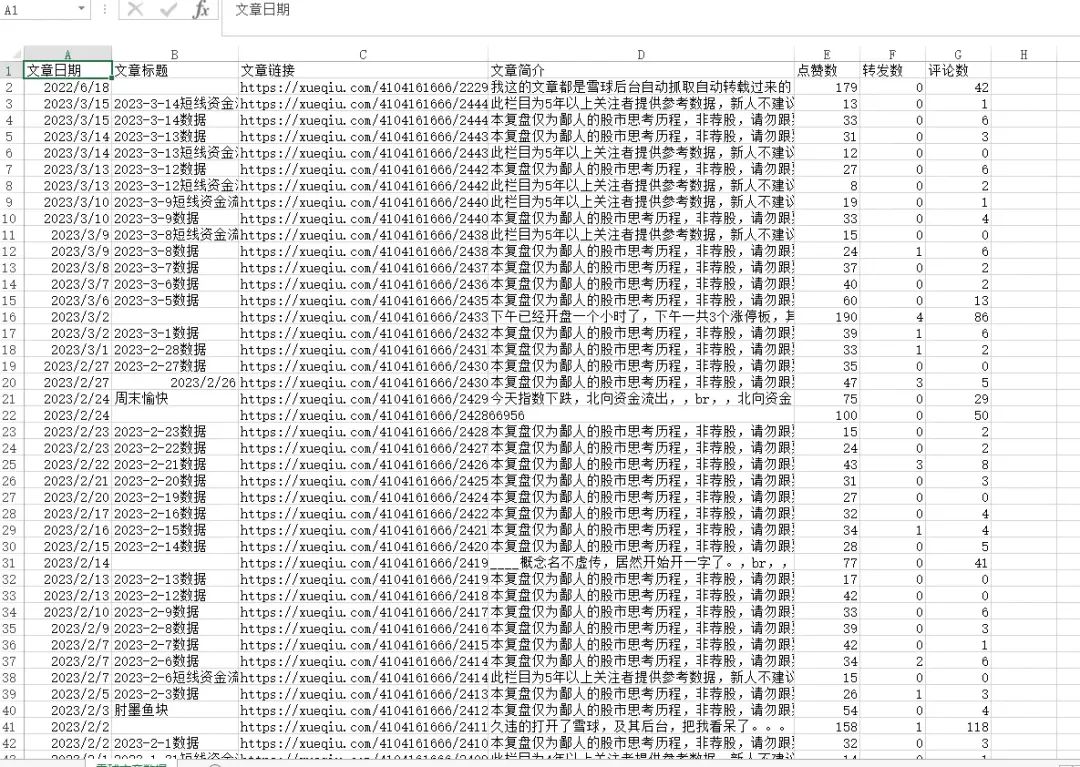

下载的文章html: 以及文章数据excel,包含文章日期,文章标题,文章链接,文章简介,点赞数,转发数,评论数:

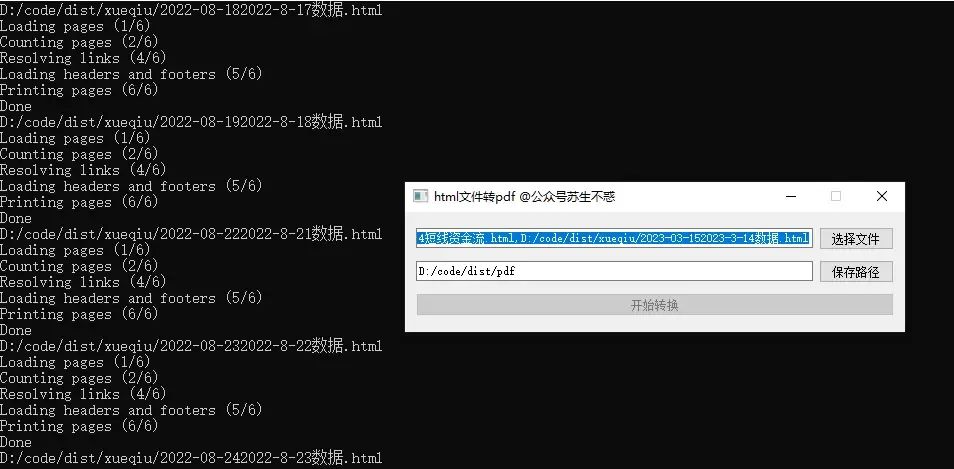

以及文章数据excel,包含文章日期,文章标题,文章链接,文章简介,点赞数,转发数,评论数: 接着用我开发的这个工具将html评论转pdf ,由于工具依赖wkhtmltopdf,需要先下载安装这个 https://wkhtmltopdf.org/downloads.html 加入环境变量。

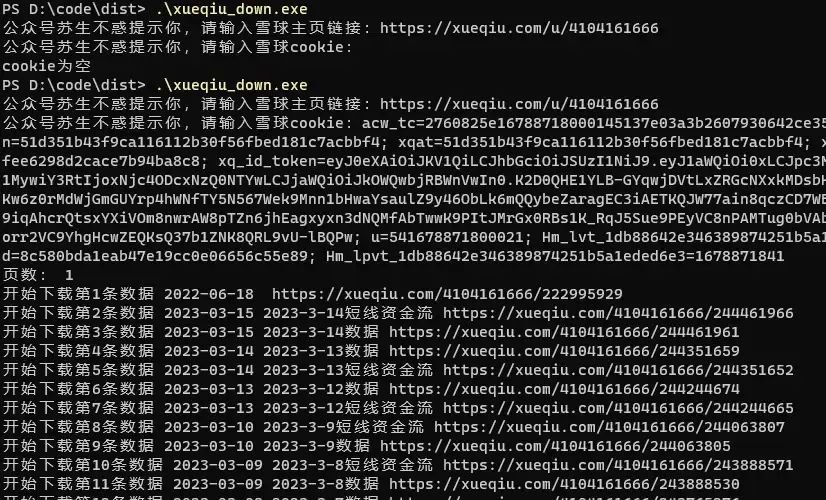

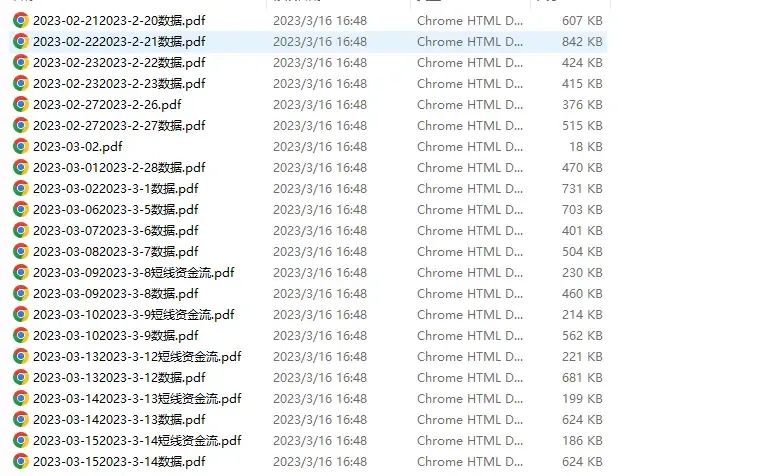

接着用我开发的这个工具将html评论转pdf ,由于工具依赖wkhtmltopdf,需要先下载安装这个 https://wkhtmltopdf.org/downloads.html 加入环境变量。 转换的pdf:

转换的pdf:

最后用我开发的这个工具将所有pdf 合并为一个带书签的pdf文件, pdf合并生成书签工具 。 效果如图:

效果如图:

批量下载市场高标解读的雪球文章pdf https://xueqiu.com/u/2201555376 ,大小226MB,网盘地址 https://pan.quark.cn/s/a95c2f5494ea

pdf转换合并

我开发的htmltopdf.exe批量转换html为pdf,它依赖,不过要注意不要放在中文目录下,否则提示错误

再用pdf_merge将pdf文件合并成一个文件。

再用pdf_merge将pdf文件合并成一个文件。

哔哩哔哩

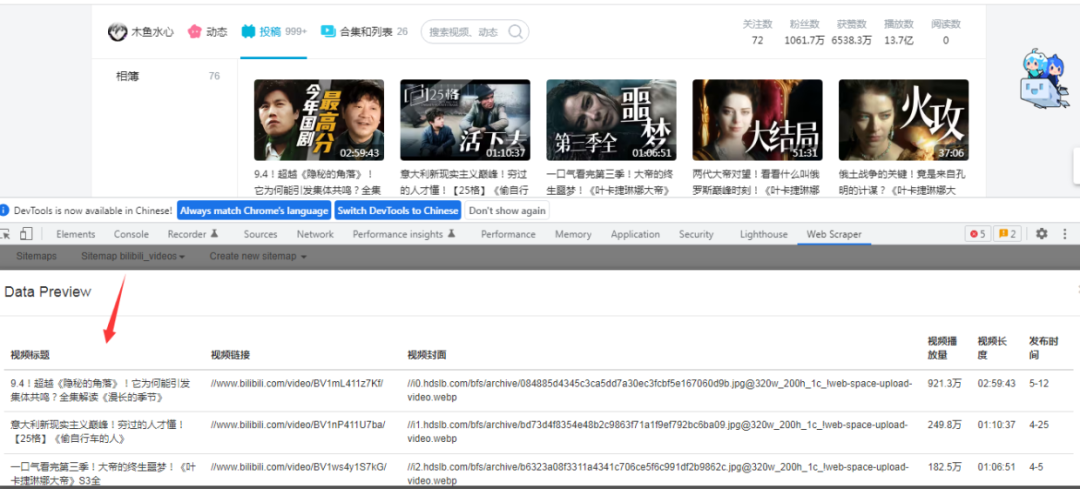

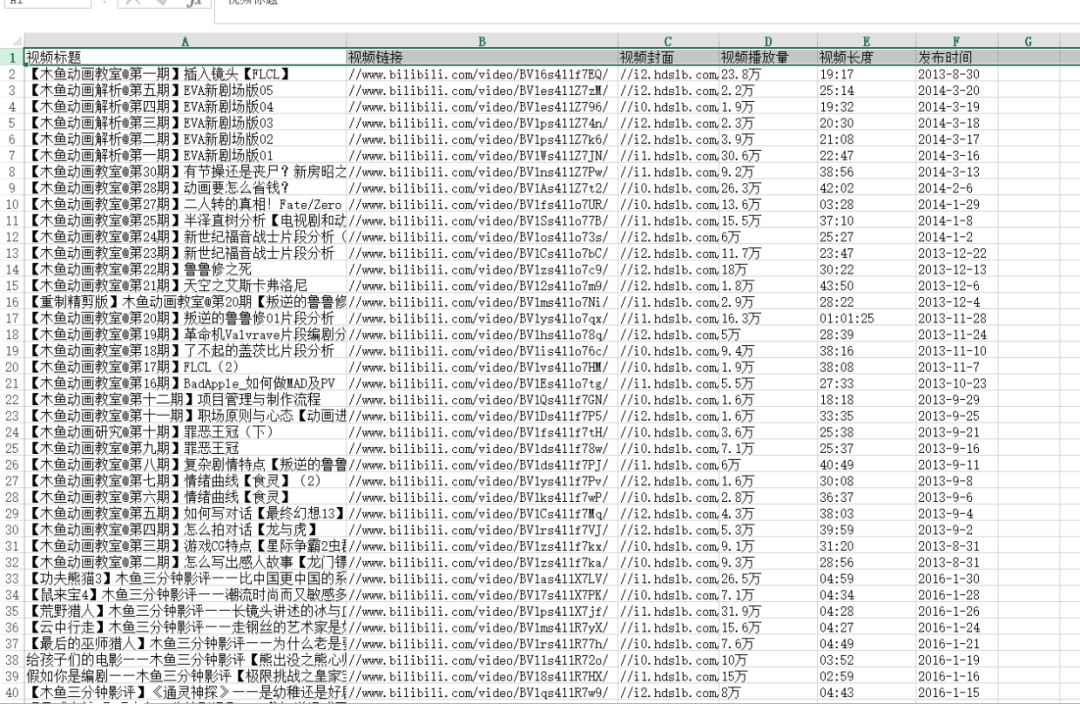

使用web scraper浏览器扩展抓取b站上木鱼水心的所有视频 https://space.bilibili.com/927587/video ,导入以下代码:

导出的excel数据包含视频标题,链接,封面,播放量,长度,时间等,从2013到2023年发布视频1200多个。 b站热榜数据抓取,导入以下代码:

b站热榜数据抓取,导入以下代码:

抖音

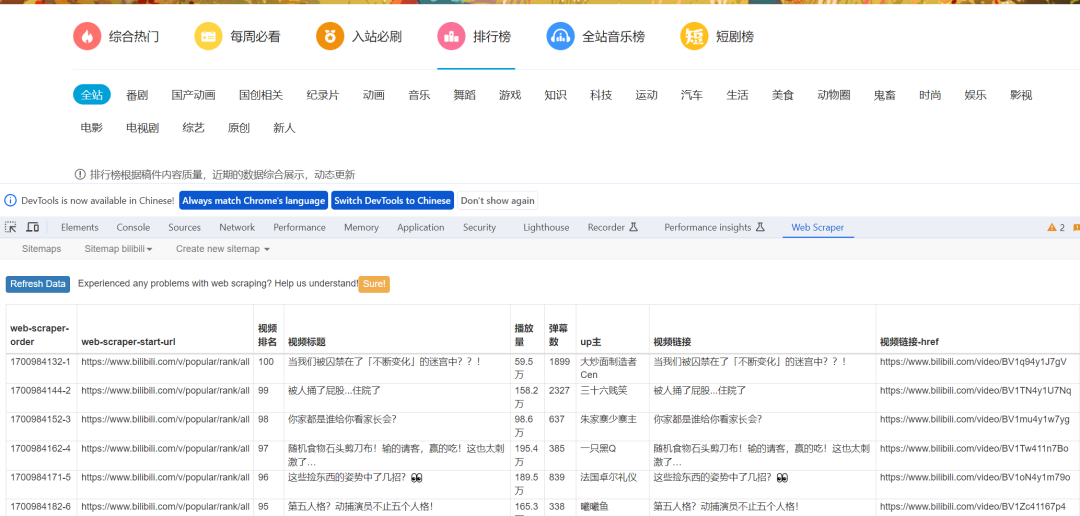

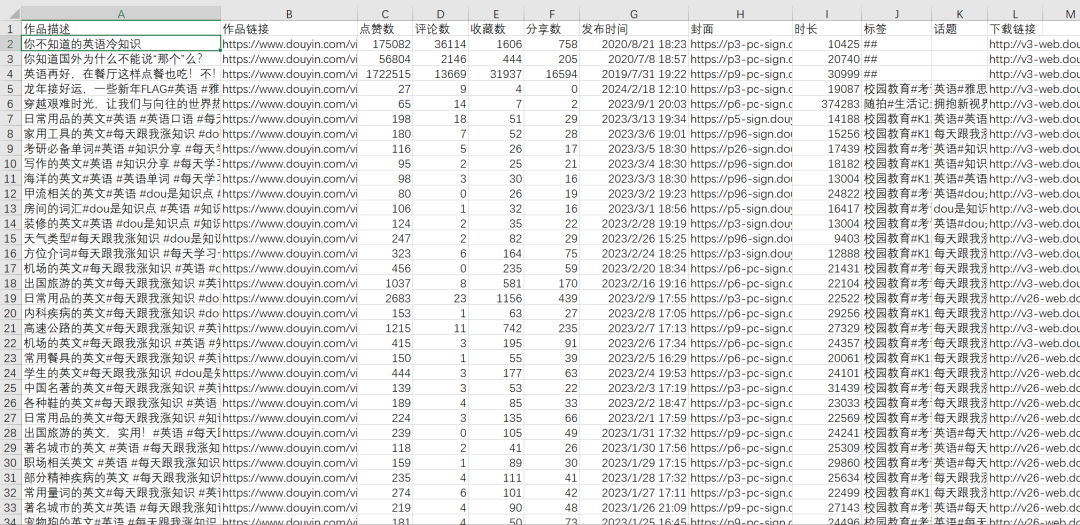

以流利说英语这个号为例 https://www.douyin.com/user/MS4wLjABAAAALnQsTEDdQDmWIZeWf-O7awwb4c733v0rpGKIF_cJVdk ,详情见之前文章2024 批量下载抖音视频,抓取导出视频excel数据包含视频标题/链接/点赞数/评论数/收藏数

导出的excel数据包含视频标题,视频链接,点赞数,评论数,收藏数,分享数,发布时间,封面,时长,标签,话题,下载链接等。

导出的excel数据包含视频标题,视频链接,点赞数,评论数,收藏数,分享数,发布时间,封面,时长,标签,话题,下载链接等。

共500多个视频。 之后再对excel里的视频链接批量下载,效果如图:

之后再对excel里的视频链接批量下载,效果如图:

小红书

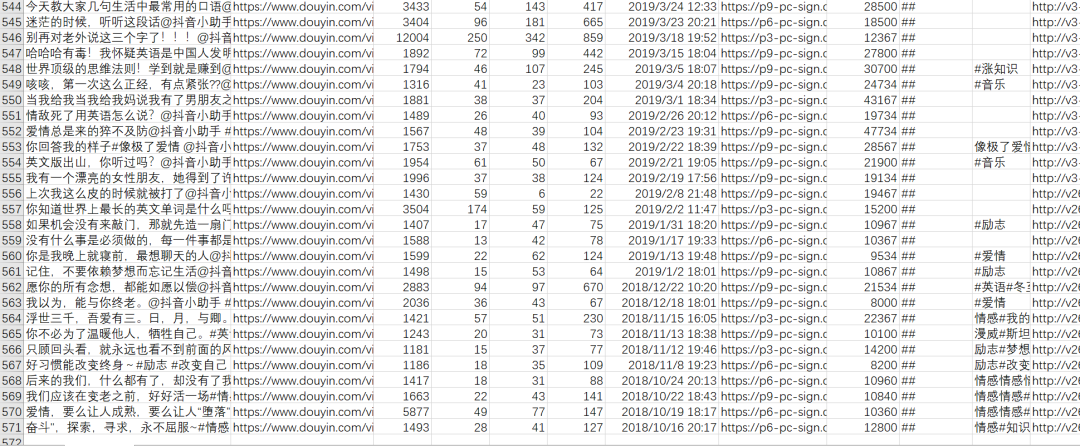

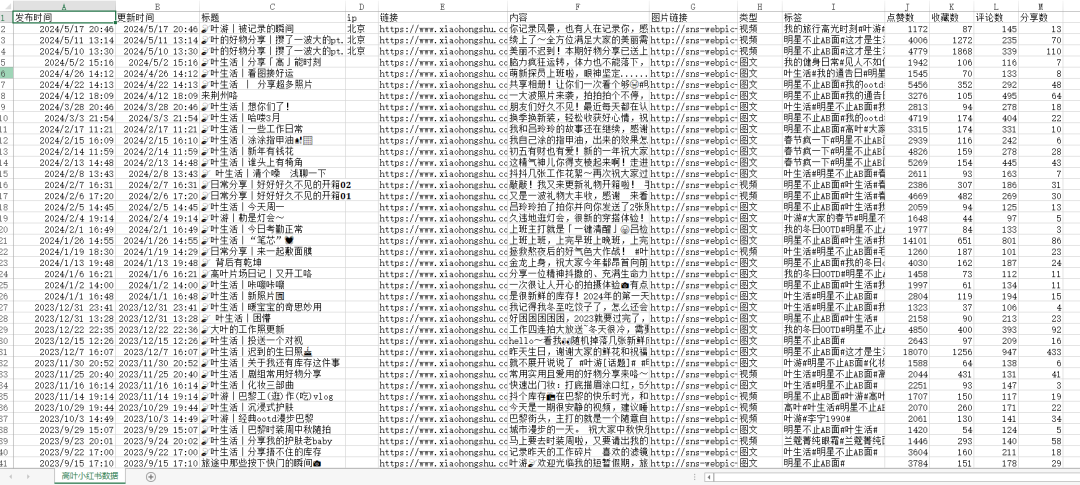

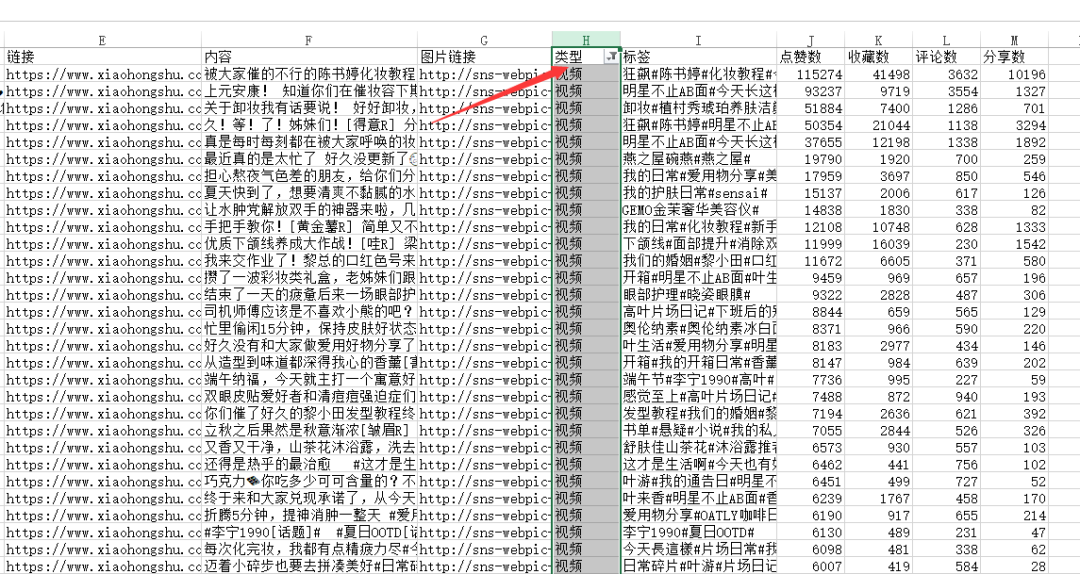

批量抓取小红书所有笔记数据2024 一键批量下载小红书图片/视频,抓取导出笔记数据excel包含发布时间,标题,链接,内容,点赞数,收藏数,评论数,分享数,导出的excel数据包含发布时间,更新时间,标题,ip,链接,内容,图片链接,类型,标签,点赞数,收藏数,评论数,分享数等。

高叶的小红书数据https://www.xiaohongshu.com/user/profile/5badf469dcf6180001b2588d如图,209条笔记其中视频105个,图文104篇。

高叶的小红书数据https://www.xiaohongshu.com/user/profile/5badf469dcf6180001b2588d如图,209条笔记其中视频105个,图文104篇。

点赞数排名前10的笔记是2023-01-31发布的 化妆教程丨和陈书婷一起狂飙!(上期) ,第一条笔记发布于2022年3月 https://www.xiaohongshu.com/explore/622d764a000000002103582f

所有笔记文案txt文件,文件名为发布时间加标题,方便搜索,当然也可以导出word:

本文地址:http://lianchengexpo.xrbh.cn/quote/11585.html

迅博思语资讯 http://lianchengexpo.xrbh.cn/ , 查看更多

本文地址:http://lianchengexpo.xrbh.cn/quote/11585.html

迅博思语资讯 http://lianchengexpo.xrbh.cn/ , 查看更多